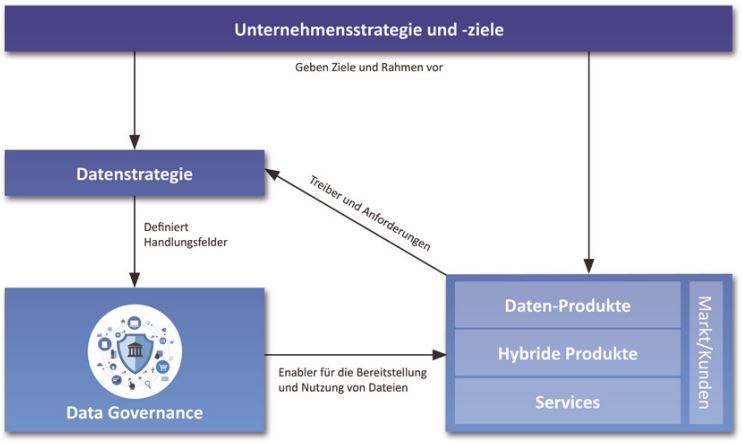

Abb. 1: Zusammenspiel von Datenstrategie und Data Governance

Im Rahmen eines Datenstrategieprojekts erkannte die Unternehmensführung das Potenzial, Daten, Analysen und Reportings zu nutzen, um Wettbewerbsvorteile für das eigene Dienstleistungsangebot zu gewinnen, das in der Beschaffung und Vermittlung von Dienstleistungen für Firmenkunden besteht. Strategisches Ziel ist die Weiterentwicklung des Geschäftsmodells von der Unterstützung einzelner Beschaffungsmaßnahmen zum Management des gesamten Beschaffungsprozesses für den Firmenkunden: beginnend mit der Lieferantenbewertung und Auswahl über die Ausschreibung und Vertragsverhandlung bis hin zur Abwicklung des Einkaufs der einzelnen Dienstleistung für den Firmenkunden. Der Outsourcing-Dienstleister erwartet davon eine starke Steigerung der Kundenbindung und das Erschließen neuer Umsatzpotenziale. Als zentraler Erfolgsfaktor wurde die Fähigkeit identifiziert, die eigenen Services durch den Einsatz datenbasierter, automatisierter Entscheidungen, unter anderem auf der Basis künstlicher Intelligenz, in einer für die Branche bislang neuen Weise zu optimieren. Durch die Reallokation der Nachfrage auf Basis automatisierter Preis- und Qualitätsvergleiche auf günstigere Anbieter konnten die Preise im Ausschreibungsprozess mit in Tausenden zählenden Anbietern auch durch die Nutzung von Skaleneffekten deutlich gesenkt werden. Der hohe Automatisierungsgrad der Auswahlentscheidungen konnte die Prozesskosten für die Firmenkunden deutlich reduzieren.

Um die Algorithmen für die Prozesssteuerung auf eine breitere Basis zu stellen, bot das Unternehmen seinen Kunden an, eigene, auch historische Daten zu den Geschäftsprozessen bereitzustellen: Da die Daten der Kunden mit den Daten des Dienstleisters im Data Warehouse (DWH) integriert wurden, konnte dieser den Kunden ein transparentes Reporting über die eigenen Geschäftsprozesse anbieten. Dies bedeutete für viele Firmenkunden erstmals, über ein integriertes Bild von Aufwand und Preisen der beschafften Dienstleistungen über alle Beschaffungskanäle und Dienstleister hinweg zu verfügen.

Die hohe Qualität der Serviceprozesse und die Etablierung von Business Intelligence als integralem Bestandteil des Serviceprodukts befeuern nun die Gewinnung von Neukunden und steigern das Transaktionsvolumen und die Bindung von Bestandskunden.

Datenstrategie für ein Leuchtturmprodukt

Das Beispielunternehmen richtet seine Unternehmensstrategie konsequent auf die Einfachheit der Outsourcing-Prozesse aus und möchte seinen Kunden im Vergleich zum Wettbewerb konkrete Mehrwerte bieten. Um dies zu erreichen, bestanden in der Unternehmensführung bereits Ideen und Vorstellungen, wie Outsourcing-Prozesse durch die Nutzung interner Daten und externer Kundendaten optimiert werden können. Da sich dies jedoch auf einen Großteil der Abteilungen auswirken würde und deshalb ein systematisches Vorgehen nötig war, fiel die Entscheidung, einen ersten Schritt zu einer unternehmensweiten Datenstrategie anhand eines Leuchtturmprodukts zu gehen und umzusetzen. Ziel dieser Strategie sollte es sein, die vorhandenen Ideen im Rahmen eines Leuchtturmprodukts zu detaillieren und die notwendigen Schritte zu deren Umsetzung zu definieren.

Da üblicherweise eine Vielzahl von Mitarbeitern der Kunden auf das Angebot des Outsourcing-Dienstleisters zugreifen und aus diesem bestellen können, war das Ziel des Leuchtturmprojekts, für die verantwortlichen Einkäufer eine höhere Transparenz über den Bestellprozess zu schaffen. Dazu zählen neben dem Bestellvolumen und den Preisen in regionaler und organisatorischer Zuordnung auch Informationen über die Preisreduzierung in den Vertragsverhandlungen, die Ersparnisse im Vorjahresvergleich, Kennzahlen zur Verfügbarkeit der Dienstleistungen sowie verschiedene Preis-Benchmarks, etwa zu Unternehmen der gleichen Branche oder zu anderen Anbietern. Darüber hinaus werden dem Einkäufer Analysen zum Verhalten der Mitarbeiter im Beschaffungsprozess angeboten, wie die Einhaltung der Preisrichtlinien, die wiederum Einfluss auf die Kosten und die Prozessqualität hat. Damit unterstützen die Analysen auch Managementaufgaben und die Prozessverbesserung bei den Firmenkunden. Für die Vorbereitung des Leuchtturmprodukts gingen die Projektverantwortlichen wie folgt vor:

- Ausarbeitung des Leuchtturmprodukts: In Workshops und Expertenrunden wurden die vorhandenen Ideen detailliert ausgearbeitet, der Kundennutzen bewertet, ein erstes Kunden-Feedback eingeholt und die technische Umsetzbarkeit geprüft.

- Datenanalyse: Prüfung, ob die relevanten Daten für die Umsetzung des Leuchtturmprodukts in benötigter Form, Qualität und Frequenz verfügbar und nutzbar sind.

- Analyse der notwendigen Aufbereitung und Integration der Daten: Klärung, wie der konkrete Nutzen aus den Daten für das geplante Produkt generiert werden kann. Dies kann vom simplen Reporting bis zu hochkomplexen Machine-Learning-Algorithmen reichen.

- Definition des Zielbildes und Abgleich mit dem Ist-Zustand: Aus dem Abgleich ergeben sich die Anforderungen an Organisation und Prozesse, Skills und Technologie des Unternehmens und seiner Abteilungen, die für eine Umsetzung des Leuchtturmprodukts notwendig sind.

- Planung der Operationalisierung: Die notwendigen Aktivitäten pro Dimension werden in den jeweiligen Aufwänden geschätzt und anschließend priorisiert, um daraus eine Roadmap zur Erreichung des definierten Zielbildes abzuleiten.

Abb. 2: Prozessschritte zur Erstellung der Roadmap

Auf Basis der Ergebnisse aus der Datenstrategie setzte der Outsourcing-Dienstleister ein Programm auf. Dabei wurde schnell klar, dass durch die Tragweite und den Einfluss auf die Organisation des Programms Mechanismen notwendig sind, die sicherstellen, dass die notwendigen Änderungen umgesetzt werden und auch nach Abschluss des Programms und der Übergabe in die Linienfunktionen aktiv gesteuert werden. Hier verzahnen und ergänzen sich Datenstrategie und Data Governance nahtlos: Data Governance unterstützt das Management bei der effektiven Umsetzung der Datenstrategie und definiert einen Rahmen für deren Verankerung in den Abteilungen und Prozessen des Unternehmens.

Data Governance als Enabler

Die Entwicklung des Leuchtturmprodukts und damit die Operationalisierung der Datenstrategie stellten den Dienstleister vor mehrere Herausforderungen:

- Die Bereitstellung eines Reportings, auf dessen Basis die eigenen Kunden Managemententscheidungen treffen, erforderte eine sehr hohe Datenqualität (DQ), die nun als Bestandteil der Qualität des gesamten Service vom Kunden wahrgenommen wurde.

- Die Verantwortung für die Servicequalität lag damit nicht mehr nur bei den unmittelbar an der Serviceerbringung beteiligten Abteilungen, sondern auch bei allen datenliefernden Bereichen des Unternehmens. Nicht nur die Datenintegration, auch die fortlaufende und bereichsübergreifende Verantwortung für die Datenqualität verlangte daher das Aufbrechen der Datensilos und die Organisation einer übergreifenden Zusammenarbeit.

- Sowohl für die Rückverfolgung von Datenqualitätsproblemen als auch für die Impact-Analyse bei Systemänderungen, die unerwartete Auswirkungen in den Kunden-Reports verhindern soll, war ein vollständig dokumentierter Datenfluss notwendig. Ein Kriterium für Datenqualität war die fachlich korrekte, konsistente und dokumentierte Definition der Kennzahlen. Diese Definitionen dienen den Kunden als Metadaten zur Interpretation der Reports. Darüber hinaus musste die Definition mit einer fachlichen Verantwortung im Unternehmen für diese Kennzahl verbunden werden, um unkoordinierte Veränderungen zu verhindern.

Diese Herausforderungen, Leistungen und Kompetenzen können über das Einführungsprojekt hinaus nur durch die Etablierung eines Management-Frameworks für Data Governance nachhaltig gesichert werden. Rückenwind bekam die Data-Governance-Initiative durch die strategische Ausrichtung des Unternehmens am Leuchtturmprodukt und die Fokussierung der Geschäftsführung auf die notwendigen Rahmenbedingungen für dessen Erfolg: Aus der Datenstrategie wurde gemeinsam mit der Geschäftsführung die Strategie der Data-Governance-Initiative abgeleitet, die Ziele, Kompetenz und Selbstverständnis formulierte und dem Data-Governance-Team im Aufbau Identität und Selbstbewusstsein gab.

Die Führung der virtuellen Data-Governance-Organisation wurde dem DWH-Bereich zugeordnet, der zwischen den Fachbereichen und der IT steht. Nach der Definition der Rollen und Verantwortlichkeiten, unter anderem für die Data Stewards in den Fachbereichen und die Data Custodians überwiegend im DWH, wurden in den Fachbereichen und im DWH Mitarbeiterinnen und Mitarbeiter für das Data-Governance-Team geworben, die sich die Unterstützung der Datennutzung und die Verbesserung der Datenqualität zur Aufgabe machen.

Das Data-Governance-Team definierte Spielregeln und Richtlinien wie zum Beispiel für die Impact-Analyse und die verbindliche Information bei allen inhaltlichen und technischen Änderungen von Daten oder für ein Vorgehen bei der Änderung von Kennzahlen.

Das erste Produkt des Data-Governance-Teams war das Metadatenmanagement in Form eines Datenkatalogs zur Erfassung der Data Lineage, der Kennzahlendefinitionen und der Verantwortlichkeiten der Daten. Der Datenkatalog wurde zunächst pragmatisch in einer Abfolge von Excel-Sheets modelliert und enthält die fachliche Definition von Kennzahlen und Attributen, die datenliefernden Systeme sowie die Verantwortlichen beziehungsweise Ansprechpartner. Der Datenkatalog unterstützt in dieser Form bereits die Suche nach den Ursachen von DQ-Problemen und die Zusammenarbeit bei der Lösung. Mittlerweile läuft die Ausschreibung für eine professionelle Data-Dictionary-Lösung, die dann unter anderem eine vollständige Data Lineage sowie Informationen zu den DQ-Maßnahmen und Regeln enthalten wird.

Das zweite Produkt ist eine Softwarelösung für das Monitoring der Datenqualität im Data Warehouse. Die Prüfregeln werden im Data-Governance-Team durch die Data Stewards unter Beteiligung weiterer Experten aus den Fachbereichen abgeleitet und selbstverständlich auch im zukünftigen Datenkatalog dokumentiert.

Die Data Stewards dokumentieren und definieren den fachlichen Inhalt von Kennzahlen und Attributen im Datenkatalog. Sie analysieren Datenqualitätsprobleme fachlich und steuern deren Behebung. Die Data Custodians analysieren mit fachlicher Unterstützung der Data Stewards DQ-Probleme im DWH und entlang der Datenbewirtschaftungskette. Sie übersetzen fachliche Prüfregeln in Datenbankabfragen, ergänzen das DQ-Monitoring um technische Prüfungen und überwachen die Resultate.

Die Zusammenarbeit zwischen Data Stewards und Data Custodians erfolgt bei DQ-Problemen situativ. Der Zeitaufwand für diese Aufgaben sowie die Regel-Meetings des Teams werden derzeit gemessen. Es ist geplant, in Abhängigkeit von den Ergebnissen für diese Aufgaben ein dediziertes Zeitbudget einzuräumen.

Die regelmäßige Zusammenarbeit im Data-Governance-Team reduziert die Fehlerbehebungszeiten. Die Kommunikation der Kolleginnen und Kollegen, die sich die Förderung exzellenter Datennutzung und Qualität auf die Fahnen geschrieben haben – innerhalb des Teams, aber auch in die Fachbereiche hinein –, erweist sich inzwischen als Treibstoff für die Data-Governance-Initiative.

Erfolgsfaktoren

Entscheidender Erfolgsfaktor für die Umsetzung der Datenstrategie und die Einführung von Data Governance war die Initiative und der Rückhalt der Unternehmensführung. Deren Fokus lag klar auf der Servicequalität und dem Kundenerlebnis und gab mit der Auswahl des Leuchtturmprodukts eine Orientierung für die Priorisierung des Programms. Aber auch die Motivation der Mitarbeiter und deren Verständnis für die Notwendigkeit, das Silodenken aufzulösen, waren wichtige Faktoren im Prozess.

Ein dritter Erfolgsaspekt war, den Kundennutzen in den Mittelpunkt zu stellen und frühzeitig das Leuchtturmprodukt über Use-Cases mit Pilotkunden zu erproben, Feedback aufzunehmen und in der Ausgestaltung des Produkts zu berücksichtigen. Schließlich ist es empfehlenswert, sich im ersten Schritt auf einen realistischen Umfang zu fokussieren und nicht alles auf einmal umsetzen zu wollen.

Üblicherweise sind bei so einem Programm viele Bereiche eines Unternehmens involviert, von Businessfunktionen bis zur IT. Daher ist ein starkes Programmmanagement, das die Gesamtkoordination übernimmt, unerlässlich.

Resultate und Nutzen

Die datengetriebenen Services und Reports konnten in einer ersten Stufe ihren Kostenvorteil und den Transparenzgewinn im Einsatz bei einem Pilotkunden unter Beweis stellen. Die so gewonnene Referenz unterstützt die Neukundenakquise maßgeblich. Der Erfolg treibt nun die Weiterentwicklung der Services und Reports voran. Durch die Umsetzung der in der Datenstrategie identifizierten Maßnahmen (Organisation und Prozesse, Skills und Technologie) und die Etablierung einer Data-Governance-Organisation in der Rolle als Enabler kann der Dienstleister in kurzen Zyklen qualitativ hochwertige und zuverlässige neue Datenprodukte und Services entwickeln und seinen Kunden zur Verfügung stellen.