Die Kreditwürdigkeitsprüfung zur Vergabe von Krediten ist schon seit längerem ein (teil-)automatisierter Prozess. Während Kredite vor 100 Jahren noch anhand eines Bauchgefühls vergeben wurden, werden mittlerweile strategisch Eigenschaften eines potenziellen Kreditnehmers gesammelt und ausgewertet. Die genutzten Methoden zur Entscheidungsfindung reichen hier von einer einfachen Einkommens oder Vermögensprüfung über die Erstellung eines KreditScores bis zum Einsatz von KI auf Basis großer Datenmengen, die inhaltlich von der Zahlungshistorie bis zum persönlichen Musikgeschmack reichen können. Durch KI Modelle versprechen sich Kreditgeber ein exakteres Scoring, das weniger Zeit benötigt als zuvor oder sogar komplett automatisiert vorgenommen werden kann.

Außerdem ist es durch die Nutzung alternativer Datenquellen im Zusammenspiel mit zuver lässigen KI Modellen möglich, auch Kreditnehmer zu beurteilen, die über keine umfassende Kredithistorie verfügen [1]. So nutzt auch das Unternehmen Upstart für die Kreditwürdigkeitsprüfung Daten wie den Bildungsabschluss und den Werdegang potenzieller Kreditnehmer in einem eigenen KI Modell. Es prognostiziert so das Zahlungspotenzial, anstatt die Vergangenheit der Personen zu betrachten – und kann deshalb mehr Menschen Kredite gewähren [6]. Im optimalen Fall bedeutet das also, dass eine zuverlässigere, schnellere und umfassendere Kreditwürdigkeitsprüfung zu insgesamt mehr und profitableren Kreditvergaben führt. Das wäre idealerweise sowohl für Kreditnehmer als auch Kreditgeber günstig.

Welche Probleme und Heraus- forderungen bringt KI mit sich?

In unserer weniger idealen Welt treten bei der Nutzung von KI aber meist auch Nachteile auf. Zur Nutzung von KI Systemen sind Trainingsdaten notwendig, anhand derer Muster und Zusammenhänge identifiziert werden. Sind diese Trainingsdaten allerdings nicht umfangreich oder ausgewogen genug, kann es zu Verzerrungen bei der Entscheidung kommen, wodurch beispielsweise bestimmte Personengruppen bevorzugt behandelt oder andere diskriminiert werden. Hier spricht man von Datenselektions Bias.

Durch die Fütterung des Modells mit solchen Daten werden enthaltene Vorurteile verstärkt und weiterverbreitet [9]. Beispiele dafür gibt es viele, seit die Nutzung von KI Systemen gängige Praxis geworden ist: vom Geschlecht abhängige Kreditlimits bei der Apple Card [12] oder das Ablehnen eines Kredits aufgrund der vom Kreditnehmer gesprochenen Sprache und seines Wohnorts [10].

Bei der Kreditwürdigkeitsprüfung, bei der entschieden wird, ob eine Person einen Kredit bekommt (und zu welchen Konditionen), kann die Entscheidung des Modells den betroffenen Kreditnehmer persönlich stark beeinflussen. Es ist also besonders problematisch, wenn hier automatisiert Entscheidungen auf Basis von Daten getroffen werden, die einen Bias enthalten. Bestimmte Merkmale wie Geschlecht, Wohnort und Nationalität werden daher von vornherein für die Prüfung der Kreditwürdigkeit nicht berücksichtigt. Diesen Ansatz nennt man Feature Selection. Es ist allerdings nicht auszuschließen, dass andere Merkmale, wie beispielsweise das Einkommen einer Person, Korrelationen zu ausgeschlossenen Features aufweisen und diese somit doch Einfluss auf die Bewertung nehmen können.

Die genutzten Daten sind zusätzlich dazu häufig persönlicher oder sensibler Natur. Der verantwortungsvolle Umgang mit ihnen muss also gewährleistet sein – vor allem, wenn die Prüfung an Drittanbieter ausgelagert wird und somit die Weitergabe der Daten notwendig ist.

Ein letztes Problem betrifft die Kommunikation gegenüber den Kunden. Ob die Entscheidung mit Hilfe von KI getroffen wurde, ist für die Kundinnen und Kunden meist nicht ersichtlich. Hier wird von Verbraucherschutzorganisationen gefordert, dass eine höhere Transparenz geschaffen wird [9].

Welche Regelungen und Richtlinien beeinflussen die Nutzung bisher?

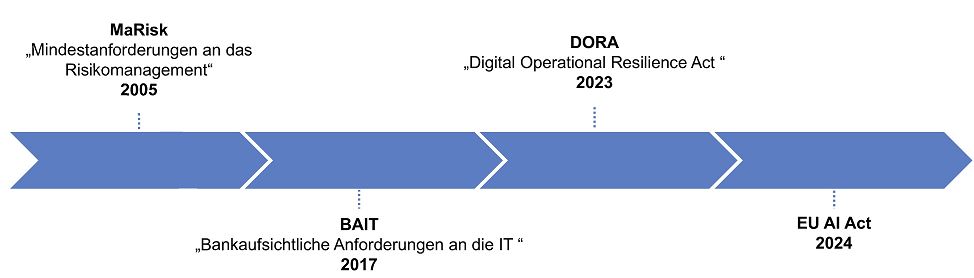

Für den Einsatz von KI im Bankensektor gibt es regulatorische Rahmenbedingungen, die auch heute schon in Kraft sind und Anforderungen beispielsweise an die Sicherheit und den Datenschutz stellen (Abb. 1). So gilt auch im Umgang mit KI Systemen und damit im Umgang mit personenbezogenen Daten die Allgemeine DatenschutzGrundverordnung (DSGVO). Die Anpassung des Allgemeinen Gleichbehandlungsgesetztes (AGG) in Hinblick auf die Diskriminierung von Personengruppen beim Einsatz von KI Systemen wird diskutiert, da Regelungslücken momentan dafür sorgen, dass dieses Gesetz keine Anwendung findet [2].

Abb. 1: Ausgewählte Regelungen/Richtlinien für den Einsatz von KI im Bankensektor

Neben der DSGVO bestehen Verwaltungsleitlinien in Form von Rundschreiben der Bundesanstalt für Finanzdienstleistungsaufsicht (BaFin), die bei Verwendung von KI im Bankensektor Richtlinien vorgeben. Dazu gehören die „Bankaufsichtlichen Anforderungen an die IT“ (BAIT) und die „Mindestanforderungen an das Risikomanagement“ (MaRisk).

Als Reaktion auf die steigende Anzahl an Cyberangriffen und bekannten Informationssicherheitsrisiken ist auf Gesetzesebene Anfang 2023 die Verordnung DORA (Digital Operational Resilience Act) in Kraft getreten und muss ab Januar 2025 verpflichtend umgesetzt werden. Die Europäische Kommission verfolgt mit DORA das Ziel, ein einheitliches Regelwerk zu schaffen, und konkretisiert die in den vorherigen Richtlinien genannten Anforderungen. Um Doppelregulierungen zu vermeiden, wird DORA Anfang 2025 BAIT ablösen [4].

Die Richtlinie BAIT baut auf den Mindestanforderungen an das Risikomanagement (MaRisk) auf und wurde gleichzeitig zur Neuerung zur sechsten Novellierung von MaRisk aktualisiert und veröffentlicht. Beide Richtlinien setzen Inhalte aus Leitlinien auf europäischer Ebene um, die von der Europäischen Bankenaufsichtsbehörde (EBA) ausgegeben werden. In Bezug auf den Einsatz von KISystemen muss eine Bank laut MaRisk die Risiken kennen, diese identifizieren, beurteilen und steuern können. Es werden Ansprüche an die Erklärbarkeit, die Transparenz und die Zuverlässigkeit der aus dem Einsatz von KI generierten Informationen gestellt [11]. BAIT konkretisiert die Anforderungen an Banken in zwölf Bereichen, darunter IT Strategie, IT Governance und IT Betrieb, und legt fest, wie Banken ihre IT Systeme und Prozesse in Bezug auf Risikomanagement aufbauen sollen.

In der DORA Verordnung sind verstärkt Anforderungen aus den Bereichen IKT Risikomanagement und das IKT Drittparteienrisikomanagement enthalten. So müssen beispielsweise auch Dienstleister, die mit Banken zusammenarbeiten, zusätzliche Informationen an die Banken liefern oder sich im Ernstfall direkt von der zuständigen Aufsichtsbehörde überwachen lassen [3].

Der EU Artificial Intelligence Act

Zu diesen bereits bestehenden Verordnungen ist im vergangenen August eine weitere hinzugekommen – der EU Artificial Intelligence (AI) Act.

Der EU AI Act verfolgt einen risikobasierten Ansatz, bei dem je nach Risiko des KI Systems verschiedene Richtlinien eingehalten werden müssen. KI Systeme werden dafür in verschiedene Risikokategorien einsortiert (Abb. 2) [5].

Abb. 2: Risikokategorien nach dem EU AI Act

KI-Systeme mit inakzeptablem Risiko werden als gefährlich eingestuft und verboten. Dazu gehören beispielsweise Systeme, die für Social Scoring oder biometrische Identifikation verwendet werden.

KI-Systeme mit hohem Risiko können die Sicherheit oder fundamentale Rechte von EU Bürgern negativ beeinträchtigen. Sie sind der Hauptfokus des AI Act und werden grob in zwei Kategorien unterteilt: KI Systeme, die in Produkten verwendet werden, und KI Systeme, die in bestimmte Bereiche fallen, zum Beispiel kritische Infrastruktur, Grenzkontrollen oder auch essenzielle private oder öffentliche Services.

KI-Systeme mit limitiertem oder minimalem Risiko sind alle weiteren Modelle, wie beispielsweise Chatbots oder Bildgeneratoren. Hier ist durch Entwickler und Provider vor allem darauf zu achten, dass eine ausreichende Transparenz gewährleistet ist. Es muss für Endnutzer erkennbar sein, dass sie mit einem KI System interagieren. Außer dem werden Anbieter ermutigt, freiwillige Maßnahmen durchzuführen.

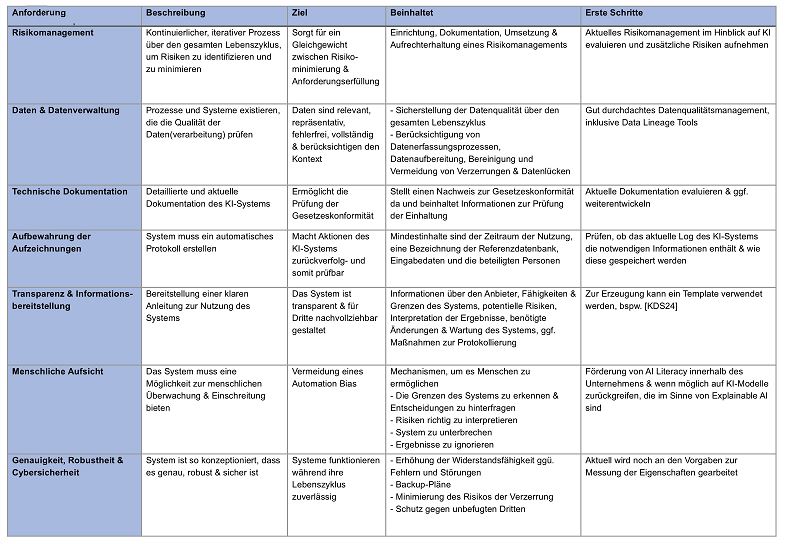

Die KI basierte Kreditwürdigkeitsprüfung fällt unter die Variante eines Hochrisikosystems, weil damit persönliche Daten automatisch verarbeitet werden, um ein individuelles Profil zu erstellen. Ein darauf basierendes Profil nimmt dann großen Einfluss auf den Zugang der Person zu finanziellen Ressourcen und allen essenziellen Leistungen, wie zum Beispiel Wohnraum, für den dieses Geld benötigt wird [5]. Als Hochrisikosystem gelten für die KI gestützte Kreditwürdigkeitsprüfung dementsprechend einige Anforderungen (vgl. Tabelle 1) und die Anbieter und Betreiber der Systeme müssen einige Verpflichtungen erfüllen.

Tab. 1: Anforderungen an Hochrisikosysteme

Der EU AI Act umfasst dabei sieben Anforderungen, die an Anbieter gestellt werden, hier also zum Beispiel an einen Finanzdienstleister, der ein KI System zur Kreditwürdigkeitsprüfung einsetzt. Dazu gehört ein kontinuierliches angepasstes Risikomanagement über den gesamten Lebenszyklus des Produkts. Dieses identifiziert, schätzt und bewertet Risiken, die mit der Nutzung des Produkts einhergehen, und setzt Maßnahmen zum Bewältigen beziehungsweise maximalen Reduzieren der Risiken um.

Außerdem muss auf eine sehr gute Datenqualität und -verwaltung für das Training, die Validierung und das Testen der KI Systeme geachtet werden. Das betrifft die Erfassung der Daten und ihre Aufbereitung in einem ersten Schritt und inkludiert auch den Ausschluss von potenziellen Verzerrungen in den Daten oder das gewissenhafte Bereinigen von Datenlücken.

Auch die technische Dokumentation unterliegt speziellen Anforderungen. Sie muss aktuell und detailliert sein, muss einen klaren Nachweis für und Informationen über das Befolgen der Regelungen enthalten. Diese Dokumentation sollte mit den anderen Informationen, die mit dem Einhalten der anderen EU Regelungen, wie BAIT oder DORA, einhergehen, gesammelt gepflegt und eingereicht werden.

Weiterhin muss das KI System automatisch Protokolle führen, das heißt, es muss Ereignisse wie das Verbinden mit einer Datenbank oder wer welche Ergebnisse geprüft hat aufzeichnen können, um die Nachvollziehbarkeit des Systems auch langfristig zu gewährleisten.

Transparenz des Systems muss in dem Sinne gewährleistet sein, dass ein Anbieter die Technologie verstehen und richtig einsetzen können muss. Das setzt eine Anleitung voraus, die zum Beispiel Informationen über den Anbieter, die Fähigkeiten und Grenzen des Systems, Risiken, die korrekte Interpretation der Ergebnisse oder Wartungsmaßnahmen enthält.

Weiterhin muss das KI System so gestaltet sein, dass es von einem Menschen überwachbar ist. Für eine Kreditwürdigkeitsprüfung bedeutet das beispielsweise, dass die vom System getroffene Entscheidung, ob jemand kreditwürdig ist, nachvollzogen werden kann. Es muss ersichtlich sein, welche Faktoren einen wie starken Einfluss auf die Entscheidung genommen haben.

Die letzte Anforderung bezieht sich auf die Genauigkeit, Robustheit und Cybersicherheit des KISystems. Ein KI gestütztes Kreditwürdigkeitsmodell muss während des gesamten Lebenszyklus konsistent funktionieren, festgelegte Eigenschaften müssen messbar sein und die Genauigkeit des Systems muss angegeben werden. Außerdem muss das System fehlerresistent und gegen Unbefugte gesichert sein und über einen Backup Plan verfügen.

Um den weitreichenden Anforderungen nachzukommen, wird zentral an Standardisierungsmaßnahmen gearbeitet [7]. Diese betreffen sämtliche Anforderungen und beinhalten zum Beispiel mögliche Risiken und entsprechende Gegenmaßnahmen oder eine Übersicht bezüglich Qualitätsattributen von Daten im Kontext von KI Systemen.

Neben diesen Anforderungen muss der Anbieter des Kreditwürdigkeits KI Systems auch einer Reihe von Verpflichtungen nachkommen. Als Anbieter gilt dabei jeder, der ein entsprechendes KISystem vertreibt, importiert, einsetzt oder verändert [5]. Das bedeutet, dass jeder, der an der Wertschöpfungskette des KI Systems beteiligt ist, auch eine Verantwortung übernehmen muss. Unter die Verpflichtungen, denen die Anbieter unterliegen, fallen beispielsweise ein sehr gutes Qualitätsmanagement, die Erstellung und Lagerung von Dokumentationen und Protokollen, eine umfassende Informationspflicht und Abhilfemaßnahmen im Schadens oder Risikofall.

Einige dieser Verpflichtungen sind für Finanzdienstleister bereits mit den anderen Verordnungen wie DORA vereinbar. Wenn also ein Finanzinstitut KI für die Kreditwürdigkeitsprüfung nutzt, ändert sich unter Umständen nicht so viel an der technischen Dokumentation. Andere Verpflichtungen, wie die Zusammenarbeit mit den Behörden oder eine Abschätzung der Folgen und Einflüsse des KI Systems auf die Grundrechte der Nutzer, sind auch für Finanzinstitute neu.

Ausblick

Der EU AI Act ist seit dem 1. August 2024 gültig. Bis zum 2. August 2026 haben nun Anbieter von Hochrisiko KI Systemen Zeit, um das Befolgen der Vorgaben umzusetzen. Sollten Unternehmen diesen Anforderungen nicht nachkommen, drohen starke Strafen: Geldbußen in Höhe von bis zu 3 Prozent ihres weltweiten Jahresumsatzes oder 15 Millionen € – je nachdem, welcher Betrag höher ist. Es wird also auch eine wirtschaftliche Frage sein, den Anforderungen und Verpflichtungen zuverlässig nachzukommen.

Die gute Nachricht für Finanzinstitute ist aber, dass sie im EU AI Act explizit bedacht wurden. Wenn sie den bisherigen Regeln folgen, folgen sie auch bereits Teilen der Verpflichtungen des EU AI Act. Dennoch sollten die neue Verordnung und weitere Entwicklungen für jeden vorliegenden Fall betrachtet werden. Explizit bedeutet das, dass Kreditinstitute jetzt anfangen müssen, sich mit dem EU AI Act auseinanderzusetzen.

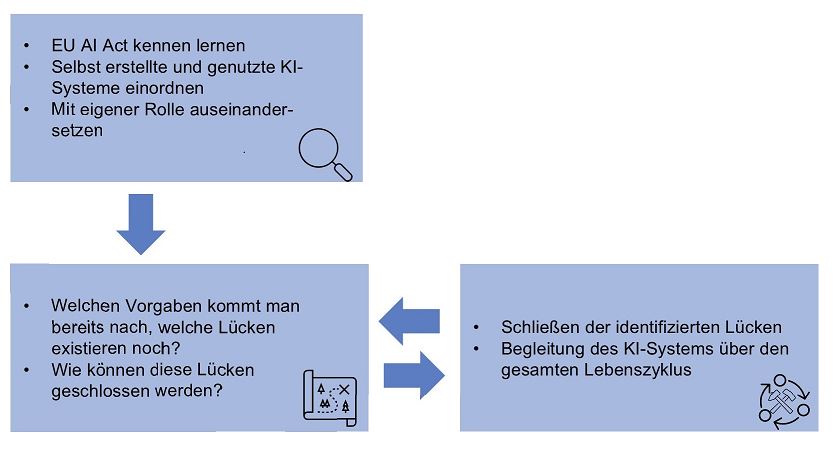

Einen ersten Schritt in diese Richtung bietet die Nutzung eines Compliance Checkers. Damit kann niedrigschwellig die eigene Rolle evaluiert und das eigene KI System auf Kritikalität geprüft werden. Sobald das geschehen ist, sollten die aktuellen Maßnahmen betrachtet werden – wo zielen sie bereits auf die neuen Anforderungen und Verpflichtungen ab und wo muss nachgeschärft werden?

Diese Erkenntnisse müssen dann initial implementiert und über den gesamten Produktlebenszyklus beobachtet und angepasst werden (Abb. 3). So besteht die beste Chance, die Kreditwürdigkeitsprüfung für Banken profitabler und auch für Kreditnehmer fair und zuverlässig zu gestalten.

Abb. 3: Vorgehen zur Umsetzung des EU AI Act

Literaturhinweise

[1] Agarwal, A. / Singhal, C. / Thomas, R.: McKinsey & Company: AI-powered decision making for the bank of the future. 23.3.2021, https://www.mckinsey.com/industries/financial-services/our-insights/ai-powered-decision-making-for-the-bank-of-the-future, abgerufen am 01.11.2024

[2] Antidiskriminierungsstelle des Bundes: Antidiskriminierungsbeauftragte will Schutz vor digitaler Diskriminierung ausweiten. https://www.antidiskriminierungsstelle.de/SharedDocs/aktuelles/DE/2023/20230830_Rechtsgutachten_KI.html, abgerufen am 01.11.2024

[3] Bundesanstalt für Finanzdienstleistungsaufsicht: Hinweise zur Umsetzung von DORA im IKT-Risikomanagement und IKT-Drittparteienrisikomanagement. 8.7.2024 / 19.9.2024, https://www.bafin.de/SharedDocs/Downloads/DE/Anlage/Aufsichtsmitteilung/dl_2024_07_08_Aufsichtsmitteilung_Umsetzungshinweise_DORA.html, abgerufen am 01.11.2024

[4] Deutsche Bundesbank: BAIT/DORA. https://www.bundesbank.de/de/aufgaben/bankenaufsicht/einzelaspekte/risikomanagement/bait-dora-598580, abgerufen am 12.9.2024

[5] EU Artifical Intelligence Act: Der AI Act Explorer.

https://artificialintelligenceact.eu/de/ai-act-explorer/, abgerufen am 01.11.2024

[6] Gudigantala, N.: AI and algorithmic fairness in consumer lending: the case of „Upstart“. In: The Journal of Business Leadership, Vol. 28, No. 1, 2020, S. 3–12

[7] Soler Garrido, J. et al.: Analysis of the preliminary AI standardisation work plan in support of the AI Act. In: JRC Technical Report, 2023

[8] Knowledge Center Data & Society: Working template for instructions for use in accordance with Article 13 AI Act.

https://data-en-maatschappij.ai/en/publications/template-instructions-for-use-onder-de-ai-act, abgerufen am 01.11.2024

[9] Klep, T. / Schneider, M.: Bundesanstalt für Finanzdienstleistungsaufsicht: Wenn ein Algorithmus über den Kredit entscheidet. 11.5.2023,

https://www.bafin.de/SharedDocs/Veroeffentlichungen/DE/Fachartikel/2023/fa_bj_2305_Algorithmen_Kreditvergabe.html, abgerufen am 01.11.2024

[10] Matzat, L. / Ruckenstein, M.: Algorithm Watch: Kreditscoring: Urteil aus Finnland wirft Fragen zur Diskriminierung auf. 21.11.2018,

https://algorithmwatch.org/de/kreditscoring-urteil-aus-finnland-wirft-fragen-zur-diskriminierung-auf/, abgerufen am 01.11.2024

[11] Sämisch, T.: Bundesanstalt für Finanzdienstleistungsaufsicht: BaFin novelliert ihre BAIT. 16.8.2021,

https://www.bafin.de/SharedDocs/Veroeffentlichungen/DE/Fachartikel/2021/fa_bj_2108_BAIT.html, abgerufen am 01.11.2024

[12] Vigdor, N.: The New York Times: Apple Card Investigated After Gender Discrimination Complaints. 10.11.2019, https://www.nytimes.com/2019/11/10/business/Apple-credit-card-investigation.html, abgerufen am 01.11.2024