Wie lässt sich der – theoretisch überzeugende – Data-Mesh-Ansatz in der Praxis anwenden? Kann er funktionieren? Wir zeigen die Synergien einer iterativen Data-Mesh-Umsetzung in Verbindung mit einer Data-Lake-/DWH-Cloud-Initiative.

Viele Data & Analytics Profis kennen die Situation: Die Geschäftswelt von heute ist geprägt von hoher Dynamik und kurzen Produktzyklen. Der kommerzielle Erfolg im kompetitiven Markt erfordert immer mehr datengestützte Optimierungen und Entscheidungen. Die Anforderungen an immer schneller verfügbare, qualitativ hochwertige Data& Analytics Anwendungen steigen. Die Menge der Daten, die zur Beantwortung der ständig wachsenden Businessfragen zur Verfügung stehen, wächst exponentiell – Statista zufolge mit einer jährlichen Wachstumsrate von 23 Prozent [Sta21].

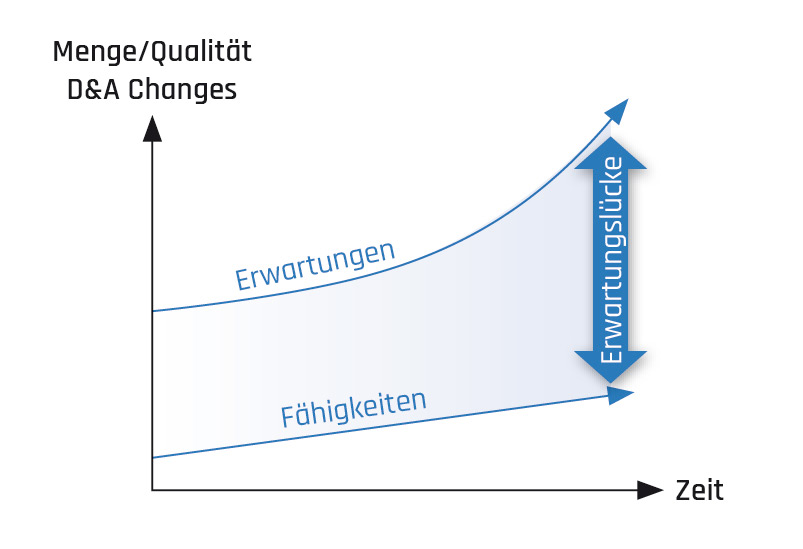

Eigentlich eine ideale Situation für interne Anbieter von Data & Analytics (D&A )Services: Ein solides Anforderungswachstum gekoppelt mit einer höheren Businessrelevanz verspricht ein gutes Geschäft. Das Problem liegt in der begrenzten Lieferfähigkeit von D&A Changes, die in vielen Firmen sowohl bezüglich Flexibilität und Durchlaufzeit neuer Anforderungen als auch hinsichtlich der Menge an Changes pro Zeiteinheit deutlich unter den Erwartungen der Stakeholder liegt. Die Folge: Es entsteht eine Erwartungslücke, die trotz Automatisierungsanstrengungen immer größer wird (vgl. Abbildung 1).

Abb. 1: Flexibilität, Skalierung und Lieferfähigkeit – die Erwartungslücke nimmt zu

Data- und Analytics-Erwartungslücke in der Praxis

Data & Analytics Erwartungslücken kommen in der Praxis immer wieder vor, wie das nachfolgende Beispiel aus der Produktentwicklung eines Unternehmens nach einer Firmenfusion zeigt. Die neu fusionierte Firma hat einen ambitionierten Business Case. Synergien am Produktportfolio müssen rasch gefunden und umgesetzt werden. Der CEO möchte einen ersten Produktlaunch in sechs Monaten erreichen. Die zwei D&A Verantwortlichen werden beauftragt, die nötigen Zahlen für Design und Rentabilität binnen eines Monats zur Verfügung zu stellen und für den Launch die entsprechenden Dashboards für die Produktstrategen sowie geeignete D&A Applikationen für Vertrieb und Kundendienst zu entwickeln. In mehreren Nachtschichten analysieren die D&A Verantwortlichen die Situation und kommen zu einem ernüchternden Ergebnis: Keine der acht Datenplattformen der beiden Unternehmen ist geeignet, die Erwartungen des CEO zu erfüllen. Zu unterschiedlich sind die D&A Plattformen hinsichtlich Businessdefinitionen, Architektur und Technologie. Ein Neubau ist schwierig umsetzbar, da dieser eine lange Projektlaufzeit (größer 18 Monate) und damit verbunden auch sehr hohe Kosten mit sich bringt. Umbau respektive Migrationsprojekte sind denkbar, jedoch auch mehr als 12 Monate entfernt. Es bleibt nur der teure und nicht nachhaltige Einsatz einer Data Science Task Force, um den Produktlaunch mit minimalem Zahlenmaterial zu unterstützen. Die unangenehme Diskussion erzeugt in der Geschäftsleitung eine D&A Erwartungslücke.

Maßnahmen gegen die D&A-Erwartungslücke

In den D&A Teams werden unterschiedliche Maßnahmen eingesetzt, um der D&A Erwartungslücke zu begegnen. Nachfolgend eine exemplarische Darstellung von häufig eingesetzten Maßnahmen:

- Neue Tools einsetzen: DWH Automatisierungstools beschleunigen den Entwicklungsprozess, Impact Analysen lassen sich mit einem Data Catalog vereinfachen, der Einsatz von PublicCloud Services verkürzt die Entwicklungszeiten.

- Team skalieren: Ein vergrößertes, zentrales D&A Team verspricht mehr und schneller umgesetzte Anforderungen.

- Arbeitsweise verändern: Verstärkter Self Service Einsatz bei Datenvorbereitung und nutzung verteilt die Arbeitslast auf mehr Schultern, der Einsatz agiler Methoden optimiert Menge und Lieferfähigkeit des zentralen D&A Teams.

Funktionieren diese Maßnahmen in der Praxis? Lässt sich damit die D&A Erwartungslücke schließen?

Die Maßnahmen leisten alle einen Beitrag zur Lösung des Problems. Viele von ihnen sind groß und komplex, wie die Einführung eines Data Catalog. Inhaltliche Abhängigkeiten und größerer Investitionsbedarf erschweren eine schlanke, schrittweise Umsetzung. Die meisten Maßnahmen ergänzen den Analytics Stack mit neuen Tools oder versuchen die Probleme mit mehr Mitarbeitern in den Griff zu bekommen. Die Tauglichkeit dieses „More of the same“ Ansatzes darf zumindest hinterfragt werden.

In vielen D&A Teams kommt es jedoch gar nicht oder sehr selten zur Umsetzung von Modernisierungsmaßnahmen. Die Auftragsbücher sind seit Jahren übervoll und die Business Stakeholder haben wenig Verständnis, wenn die geringe Baukapazität für Modernisierungsmaßnahmen „verschwendet“ wird.

Aber gibt es bessere Optionen?

Data Mesh: Ein neuer Ansatz für mehr Skalierung und Business-Mehrwert

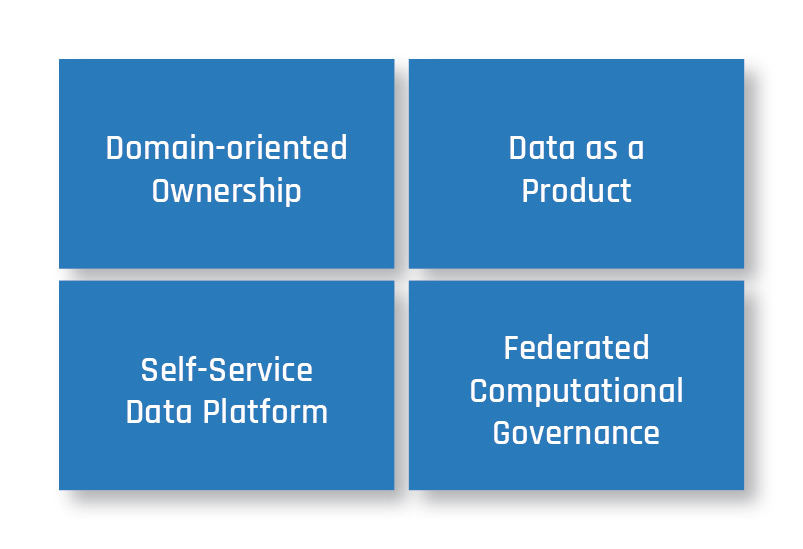

Abb. 2: Die Grundprinzipien des Data Mesh

Data Mesh ist ein neuer, ganzheitlicher Ansatz, um die D&A Erwartungslücke zu schließen. Erfunden wurde das Data Mesh 2019 von Zhamak Dehghani. Abbildung 2 zeigt die vier sich gegenseitig verstärkenden Grundprinzipien des Data Mesh [Deh22]:

- Domain-oriented Ownership (DoO): Die Verantwortung für operative und analytische Daten wird der Business Domäne zugewiesen (zum Beispiel Vertrieb, Finanzen, HR), die den Daten am nächsten ist. Die Business Domäne ist verantwortlich für Bau und Pflege von Datenprodukten. Dieses dezentrale Modell bildet die Basis für Skalierung und bringt eine größere Nähe zu den Business Inhalten der Domäne und zu operativ in dieser Domäne arbeitenden IT Teams (zum Beispiel Quellsysteme für Data Lake und DWH).

- Data as a Product (DaaP): Die Business Domänen bündeln ihr inhaltliches Wissen in Datenprodukten, die sie mit Datenanwendern (Analysten, Data Scientists) oder Maschinen teilen. Die Datenprodukte besitzen eine klar definierte, beschriebene und qualitätsgeprüfte Schnittstelle, die den Anwendern verlässlichen Zugriff auf die Daten gibt.

- Self-Service Data Platform (SSDP): Eine einheitliche Datenplattform ermöglicht den dezentralen Datendomänen, ihre Datenprodukte einfach und effizient zu bauen und zu betreiben. Die Nutzung der Datenplattform ist auf Einfachheit getrimmt und richtet sich an „normale“ IT Entwickler oder IT affine Analysten. Das schafft die Voraussetzung, dass mehr Mitarbeiter an der Erstellung von Datenprodukten beteiligt werden können.

- Federated Computational Governance (FCG): Anspruch und Realität klaffen in der Governance von D&A Plattformen oft ziemlich weit auseinander. Dieses Prinzip fokussiert primär auf Prinzipien, die automatisiert dezentral geprüft und durchgesetzt werden können. Mit diesem Prinzip können Doppelspurigkeiten, unerwünschte Silobildungen und andere unerwünschte Data Mesh Nebenwirkungen adressiert werden. Durch die Automatisierung kann die Governance auch bei steigenden Teamgrößen „mitwachsen“.

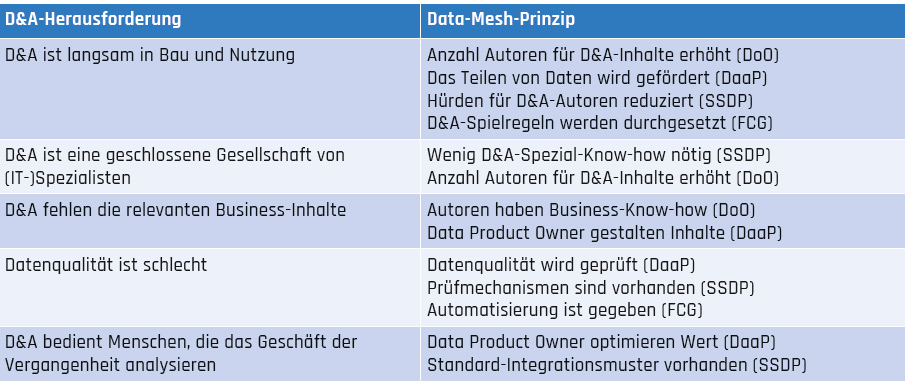

Data Mesh ist weitgehend Technologie agnostisch und kann auf Data Lake , Data Lakehouse oder DWH Architekturen angewendet werden [Deh22]. Inwiefern helfen diese Prinzipien bei der Bekämpfung der D&A Erwartungslücke? Tabelle 1 zeigt, wie die aus Projekterfahrungen des Autors begründeten D&A Herausforderungen durch DataMesh Prinzipien adressiert werden. Der Hauptfokus von Data Mesh ist die Skalierung [Deh22], die durch alle vier Prinzipien unterstützt wird. Im Unterschied zu den bisherigen Ansätzen wird die ganze Kraft der Organisation verwendet, um gezielten Mehrwert aus den Daten zu ziehen. Abbildung 3 zeigt die Hauptwirkungen der Data Mesh Prinzipien zum Schließen der D&A Erwartungslücke.

Ist Data Mesh eine Revolution für D&A?

Oberflächlich betrachtet gibt es einige Indizien für eine Revolution: Data Mesh ersetzt das zentrale Datenmodell durch kombinierbare, dezentrale Datenprodukte, das „Single Source of Truth“ Prinzip wird aufgeweicht, der Bau von Datenprodukten erfolgt dezentral, die zentrale Orchestrierung entfällt, analytisches und operatives Data Management werden zusammengeführt, Business Analysten und Software Engineers werden zu Autoren von Datenprodukten und nur die Self Service Data Platform wird zentral zur Verfügung gestellt.

Wenn man die D&A Trends der letzten Jahre Revue passieren lässt, fällt auf, dass viele aktuelle Trends in Data Mesh aufgenommen, weiterentwickelt und miteinander kombiniert wurden:

- D&A Self Service: Dieser Trend wurde vor 15 Jahren mit den BI Visualisierungs Tools gestartet und dann in die Datenvorbereitung mit Data Preparation Tools weitergeführt. Data Mesh baut auf diesem Trend auf und postuliert eine weitere Verstärkung durch mehr Dezentralisierung (DoO) und geringere technische Hürden (SSDP).

- D&A-Modularisierung: Die von den Stakeholdern geforderte Flexibilität von D&A Plattformen kann nur mit modularen Architekturen und Technologien erreicht werden. Gartner nennt diesen Trend „Composable Analytics“ [Gar22]. Data Mesh nimmt ihn mit den Datenprodukten (DaaP) auf, die Daten, Code und Zugriffstechnologien in kombinierbaren Modulen bündeln [Deh22].

- D&A-Normalisierung: D&A war in der Vergangenheit immer ganz anders als alle anderen IT Disziplinen – nicht nur bezüglich Skills und Technologien, sondern auch im Hinblick auf Vorgehen, Organisation und Business Interaktion. Die Einführung von Data Lakes hat D&A näher ans Software Engineering herangeführt, durch operativere Analytics Use Cases werden Standard API Integrationsmuster auch bei D&A salonfähig. Der Trend zu agilen Produkt IT Einheiten hat in einigen Firmen, wie zum Beispiel bei den Schweizerischen Bundesbahnen (SBB), auch die Organisation von D&A in den IT Mainstream überführt.

Tab. 1: Zusammenhang zwischen D&A-Herausforderungen und -Prinzipien

Data Mesh nimmt diesen Trend auf und dezentralisiert alle inhaltlichen Bautätigkeiten in die Business Domänen, hebt die Trennung zwischen operativ und analytisch weitgehend auf (DoO) und schafft Datenprodukte, die maschinell integrierbar sind (DaaP, SSDP). Data Mesh präsentiert sich somit als konsequente Weiterentwicklung aktueller Trends in einem Technologie agnostischen Framework. Ob Data Mesh als Revolution oder als Evolution angesehen wird, hängt primär vom eigenen D&A Kontext ab. Aus dem Blickwinkel von großen, zentralen BI Plattformen kann Data Mesh disruptiv wirken. Vom Standpunkt einer heterogenen Data Lakehouse Plattform kann das ganz anders aussehen.

Abb. 3: Hauptwirkungen der Data-Mesh-Prinzipien zum Schließen der Erwartungslücke

Praxiserfahrungen mit Data Mesh

Data Mesh existiert erst seit etwa drei Jahren und ist somit noch ein sehr junger Trend. Zwar gibt es bisher nur wenig umfassende, öffentlich zugängliche Berichte über Data Mesh Erfolge, jedoch ist der Data Mesh Hype in der weltweiten D&A Community längst angekommen. Die von Zhamak Dehghani genannten Gründe für Data Mesh [Deh22] sind für viele D&A Anwender und Manager sehr gut nachvollziehbar und versprechen Lösungen für schon lange bestehende, reale Probleme.

Einige Firmen wie Roche Diagnostics, Zalando und JP Morgan können bereits heute Data MeshErfolge vorweisen. Roche Diagnostics hat das Data Mesh gewählt, um die Analytics Strategie umzusetzen und die Maturität im Umgang mit Daten zu erhöhen [Kha22]. Zalando nutzt Data Mesh, um D&A im Unternehmen zu skalieren und mit den Datenprodukten ein neues Mindset aufzubauen [Sch22]. JP Morgan betont primär den Wert des Datenteilens, das mit Data Mesh ermöglicht wird [JPM22]. Eine Zusammenstellung von Firmenerfahrungen finden sich in der User Story Sammlung der Data Mesh Community [Dat22].

Ähnlich wie bei Roche Diagnostics begann auch bei den SBB die Data Mesh Reise mit einer neuen Analytics Strategie. Dabei waren die Grundvoraussetzungen für Data Mesh gut: Neben einem dezentralen Mindset war auch die IT bereits nach Business Domänen organisiert (inkl. Analytics). Die Data Mesh Idee kam bei den Stakeholdern gut an. Die Umsetzung der Strategie führte zum Aufbau einer cloudbasierten Enterprise Analytics Plattform. Kernpunkt der neuen Plattform ist ein Data Marketplace, der das Teilen von Datenprodukten ermöglicht. Trotz eines durchaus erfolgreichen Starts der Initiative traten auch Herausforderungen auf: die Bereitstellung des Self Service auf der SSDP, der Aufbau von dezentralen Skills und genügend Ressourcen für das zentrale Plattformteam.

Herausforderungen von Data Mesh

Die Umsetzung von Data Mesh ist nicht trivial. Zum einen werden ein neues, dezentrales Mindset sowie ein größeres Vorhaben benötigt, das deutlich über den D&A Bereich hinausgeht (organisatorische Implikationen von DoO). Zum anderen sind Zeit und Geldbedarf für eine Modernisierung mit Data Mesh substanziell. Last but not least ist die Unterstützung des Top Managements unverzichtbar. Zalando beispielsweise spricht von einem großen Commitment, das die Data Mesh Pioniere in einer Organisation benötigen [ScW21].

Die Herausforderungen beim dezentralen Bau und Betrieb kombinierbarer Datenprodukte sollten nicht unterschätzt werden. Neue Vorgehen, Architekturmuster und Technologien müssen eingesetzt werden. Sorgfältige Architekturarbeit und ein iteratives Vorgehen sind empfehlenswert. Ein besonderes Augenmerk sollte der Datenmigration der bestehenden D&A Plattformen geschenkt werden.

Iterative Einführung von Data Mesh

Wenn die Motivation für Data Mesh vorhanden ist, kommt rasch die Frage nach der Umsetzung. Data Mesh betrifft alle D&A Bereiche und kann nicht mit dem reinen Kauf eines Tools eingeführt werden. Da ein Neubau der D&A Landschaft in den meisten Unternehmen nicht in Betracht kommt, stellt sich die Frage nach einem iterativen Vorgehen. Max Schultze, Data Platform Manager bei Zalando, plädiert für einen kleinen, Use Case zentrierten ersten Schritt, der ein tatsächliches Businessproblem löst [ScW21].

Aktuell werden in vielen Firmen Cloud Initiativen für D&A gestartet oder weiter ausgebaut. Das ist ein guter Zeitpunkt, um auch erste Schritte Richtung Data Mesh zu unternehmen.

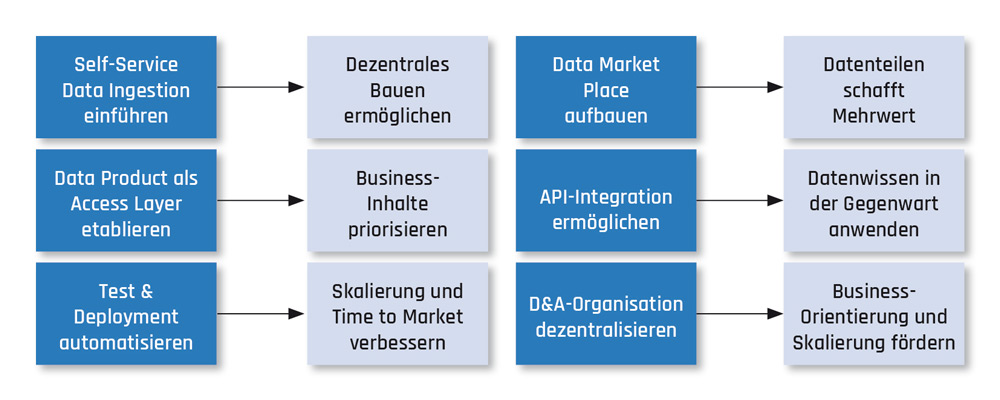

Abbildung 4 zeigt eine Auswahl möglicher Schritte in Richtung Data Mesh. Diese können einzeln oder kombiniert eingesetzt werden, je nach Bedarf und Möglichkeiten einer Organisation. Sinnvoll ist die Erstellung einer Roadmap, die quartalsweise aktualisiert wird und die Modernisierungsschritte benennt sowie in eine zeitliche Abfolge bringt. Das schafft Transparenz über die Ambition und hilft beim Erwartungsmanagement mit den Stakeholdern.

Abb. 4: Mögliche Schritte zur Implementierung eines Data Mesh

Fazit

Data Mesh ist einer der vielversprechendsten Ansätze, um die vielerorts vorhandenen D&A Erwartungslücken nachhaltig zu füllen. Das kann nur gelingen, wenn die gesamte Organisation befähigt wird, mit Daten zu arbeiten. Die dezentrale Skalierung von Verantwortung und Umsetzungsfähigkeiten, ein starker Inhaltsfokus und erheblich erweiterte Self Service Fähigkeiten versprechen D&A Kapazitäten quantitativ und qualitativ signifikant zu erweitern. Data Mesh befähigt mehr Menschen, selbst mit Daten zu arbeiten und damit die Unternehmen im Hinblick auf Datenmaturität weiterzuentwickeln.

Der Weg in Richtung Data Mesh wird für jedes Unternehmen unterschiedlich sein. Es gibt noch wenig Best Practices – aber viele D&A Pioniere, die die Erwartungen ihrer Stakeholder in Zukunft mit Data Mesh besser erfüllen wollen.

Weitere Informationen

[Dat22] Data Mesh Learning: User Stories. 2022, www.datameshlearning.com/user-stories/, abgerufen am 17.7.2022

[Deh22] Dehghani, Z.: Data Mesh – Delivering Data-Driven Value at Scale. O’Reilly 2022

[Gar22] Gartner: Use Composable Data and Analytics to Generate Business Value. https://www.gartner.com/en/webinars/3997088/use-composable-data-and-analytics-to-generate-business-value, abgerufen am 17.7.2022

[JPM22] JP Morgan: Evolution of Data Mesh Architecture can drive significant value in modern enterprise. 2022, www.jpmorgan.com/technology/technology-blog/evolution-of-data-mesh-architecture, abgerufen am 17.7.2022

[Kha22] Khawaja, O.: Data Mesh implementation journey at Roche Diagnostics. 23.2.2022, www.youtube.com/watch?v=S5ABE4bevn4, abgerufen am 17.7.2022

[Sch22] Schultze, M.: Data Mesh in Practice: How to set up a data driven organisation. 11.1.2022, www.youtube.com/watch?v=rqYFqtztWi4, abgerufen am 17.7.2022

[ScW21] Schultze, M. / Wider, A.: Data Mesh in Practice. O’Reilly 2021

[Sta21] Statista Research Department: Volume of data/information created, captured, copied and consumed worldwide from 2010 to 2025. 23.5.2022, www.statista.com/statistics/871513/worldwide-data-created/, abgerufen am 17.7.2022