Kennen Sie Aussagen wie diese: Software wird nur noch offshore getestet! Testautomatisierung lohnt sich nicht! Testmanagement wird nicht mehr benötigt! Softwarequalität hängt nur von den richtigen Entwicklern ab! KI-Systeme werden zukünftig das Testen bestimmen!

Wir wollten es genau wissen! Dazu haben wir im Frühsommer 2020 zum dritten Mal im 5-Jahres-Abstand eine der größten Umfragen im Bereich des Testens und der Qualitätssicherung (QS) im deutschsprachigen Raum erfolgreich durchgeführt. Die wissenschaftliche Leitung des Umfrage-Projekts liegt bei der Technischen Hochschule Köln und der Hochschule Bremerhaven. Ideeller, personeller (und finanzieller) Förderer ist das German Testing Board (GTB e.V.) zusammen mit dem Austrian Testing Board (ATB). Bei der Bewerbung der Umfrage unterstützten uns der ASQF e.V., bitkom, der dpunkt.verlag, der Fachbereich „Softwaretechnik” der Gesellschaft für Informatik (GI e.V.), die GI-Fachgruppe „Test, Analyse und Verifikation von Software (TAV), die Softwareforen Leipzig und das Swiss Testing Board (STB).

Der Fragenkatalog wurde bewusst ähnlich zu den vorherigen Softwaretest-Umfragen 2015/16 und 2011 gehalten, damit unsere aktuellen Analysen die damaligen Einblicke in aktuelle und zukünftige Trends und Herausforderungen rund um die Qualitätssicherung von Software und Systemen fortführen. Im Folgenden kürzen wir der besseren Lesbarkeit halber die Umfrageergebnisse aus 2015/16 mit 2015 ab.

Die Ergebnisse sollen auf der einen Seite einem möglichst breiten Interessentenkreis erlauben, Impulse für die praxis- und forschungsorientierte Ausrichtung der Ausund Weiterbildung sowie Qualifizierung abzuleiten, sowie auf der anderen Seite den Unternehmen mit den Ergebnissen Grundlagen für ein Benchmarking zur Verfügung zu stellen.

In diesem Artikel skizzieren wir das Profil der Teilnehmenden und stellen einige Ergebnisse aus der operativen Umsetzung vor, um Ihr Interesse an unseren detaillierten Analysen zu wecken.

Wer hat geantwortet?

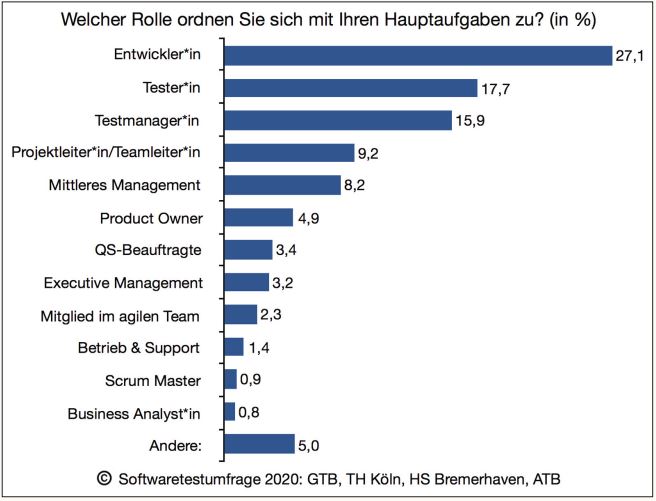

Die drei Fragebögen waren vom 5. Mai bis zum 30. Juni 2020 online. Mit 1051 (2015: 775, 2011: 1402) Teilnehmenden aus dem Bereich Entwicklung und Test (siehe Abbildung 1) sowie 196 (2015: 217, 2011: 221) aus dem Bereich Management erfuhr die Umfrage wieder erfreulichen Zuspruch. Enttäuschend ist dagegen, dass lediglich 60 Teilnehmende zur Forschung antworteten (Fragebogen zur Forschung erst ab 2015, dort: 193).

Abb. 1: Rollenzuordnung der Operativen

Interessant ist ein Blick auf die Teilnehmenden des Management-Fragebogens: Ordneten sich 2011 deutlich über 3% der Gruppe des Executive Managements zu, so waren es bei der Umfrage 2015 erfreuliche 5%, jedoch bei der aktuellen Umfrage 2020 nur noch knapp über 3%. Beim mittleren Management sind es aktuell nur noch 8% im Vergleich zu 9% im Jahr 2011 und 14% in 2015. Hat die Relevanz der Themen um Qualitätssicherung und Softwaretest in den Führungsetagen wieder abgenommen? Oder fehlt aufgrund von COVID-19 einfach die Zeit?

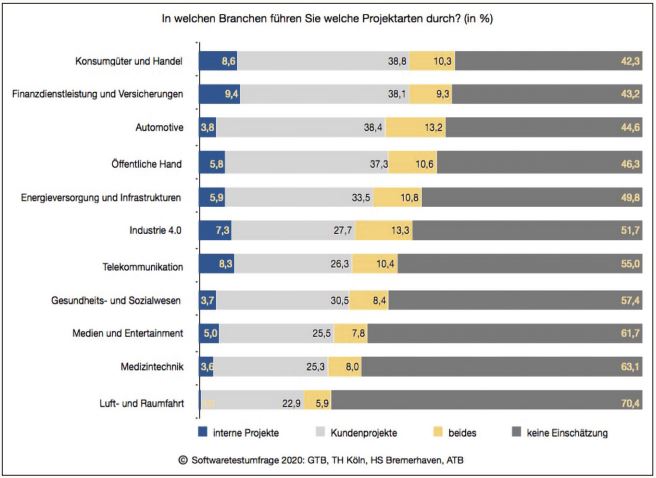

Bei den Branchen der Teilnehmenden sieht es ähnlich wie in den beiden früheren Umfragen aus, wobei hier Mehrfach-Antworten erlaubt waren (siehe Abbildung 2). Knapp vorne liegen Konsumgüter und Handel mit 58%, gefolgt von Finanzdienstleistern und Versicherungen mit 57% und Automotive mit 56% sowie der öffentlichen Hand mit 54%.

Abb. 2: Branchen und Projektarten

Agil? Oder doch (noch) nicht?

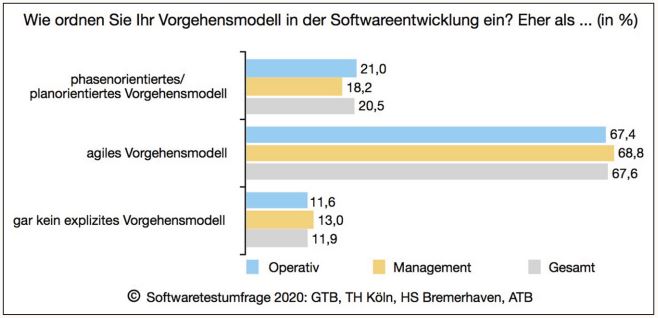

Wie erwartet sehen wir auch dieses Jahr die weitere Etablierung agiler Vorgehensweisen (siehe Abbildung 3): So geben nur noch knapp 21% der Teilnehmenden an, ein klassisches phasenorientiertes Vorgehensmodell anzuwenden (2015: 47%, 2011: 54%), wohingegen über 67% agile Vorgehensmodelle benutzen (2015: 43%, 2011: 29%).

Abb. 3: Vorgehensmodell

Befragt nach der eigenen Rolle, dominieren wie in Abbildung 1 zu erkennen immer noch klar die klassischen Rollenbilder wie Entwickler*in, Testmanager*in und Tester*in. Die agilen Rollen wie Scrum Master, Product Owner und Teammitglied sind noch in der Minderheit. Die Vision von T-Shaped-Skills in agilen Teams wird demnach nicht gelebt.

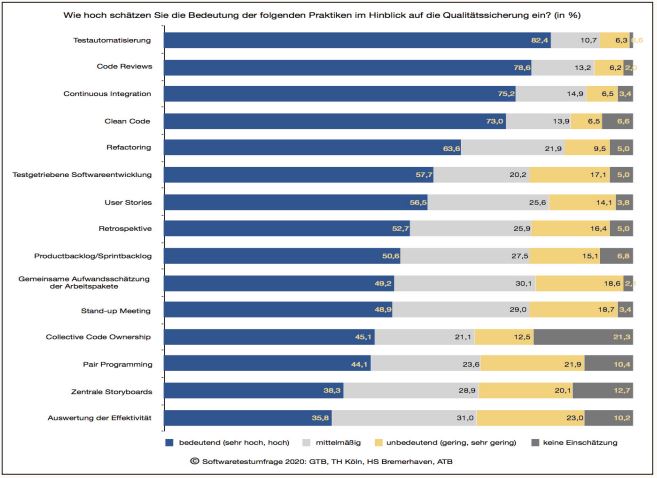

Bei der Analyse der verwendeten Praktiken im Bereich der Qualitätssicherung (siehe Abbildung 4) führen diejenigen das Ranking an, die wenig Vorbedingungen an einen agilen Mindset haben, sondern primär technisch orientiert direkt anwendbar sind: So geben z.B. 73% der Teilnehmenden an, die Clean-Code-Technik anzuwenden, 79% führen Code-Reviews durch und 74% wenden die Technik des Continuous Integration an. Die Praktiken, bei denen der agile Teamgedanke notwendige Vorbedingung ist, zeigen hier deutlich geringere Werte in Bezug auf ihre Bedeutung für die Qualitätssicherung: So wenden 45% der Teilnehmenden die Collective Code-Ownership an, 49% machen eine gemeinsame Aufwandsschätzung und 44% nutzen Pair-Programming.

Abb. 4: Bedeutung der Praktiken für die QS

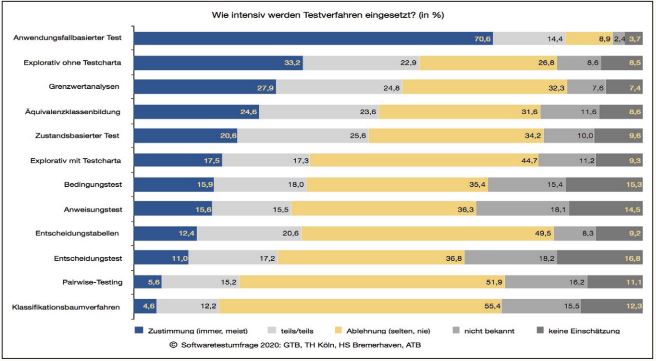

Spannend ist darüber hinaus noch, dass bei der agilen Transition viele klassische Methoden im Bereich des Testens scheinbar an Bedeutung verlieren (siehe Abbildung 5). So wenden nur noch 25% die Äquivalenzklassenanalyse regelmäßig an (2015: 38%, 2011: 61%), 12% nutzen Entscheidungstabellen (2015: 18%, 2011: 33%) und 4% greifen zur Erstellung der Testfälle auf das Klassifikationsbaumverfahren zurück (2016: 7%, 2011: 12%).

Abb. 5: Einsatz klassischer Testverfahren

Schon diese Blitzlichter zeigen, dass die Welt des Testens und der Qualitätssicherung weiter in Bewegung ist! Die Diagramme mit den Antwortverteilungen zu allen Fragen sind bereits im Internet auf der Web-Seite https://www.softwaretest-umfrage.de/.