Agilität ist mehr als nur ein Trend, kämpft aber noch mit Altlasten

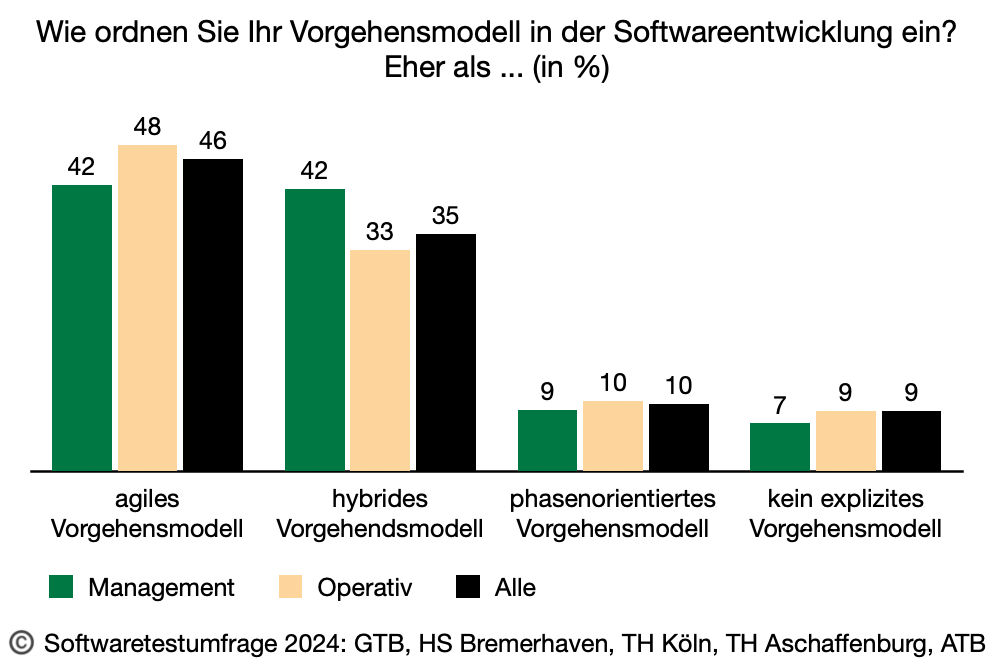

Agile Vorgehensmodelle sind weiterhin die bevorzugte Methode in der Softwareentwicklung. So geben die meisten Teilnehmenden an, ein agiles Vorgehensmodell zu verwenden (Management: 42%, operativ Tätige: 48%). Es gibt zudem eine weitere Tendenz zur Kombination agiler und traditioneller Elemente, denn 42% der Teilnehmenden aus dem Management geben an, ein hybrides Vorgehensmodell zu nutzen (siehe Abb. 1). Hybrid selbst ist nur bedingt definiert und so fällt auf, dass nur 33% der operativ Tätigen ihre Projekte als hybrid ansehen. Hier scheint eine deutliche Wahrnehmungs- oder Begriffsdiskrepanz zwischen Management und operativ Tätigen vor-zuliegen.

Abb. 1: Vorgehensmodelle

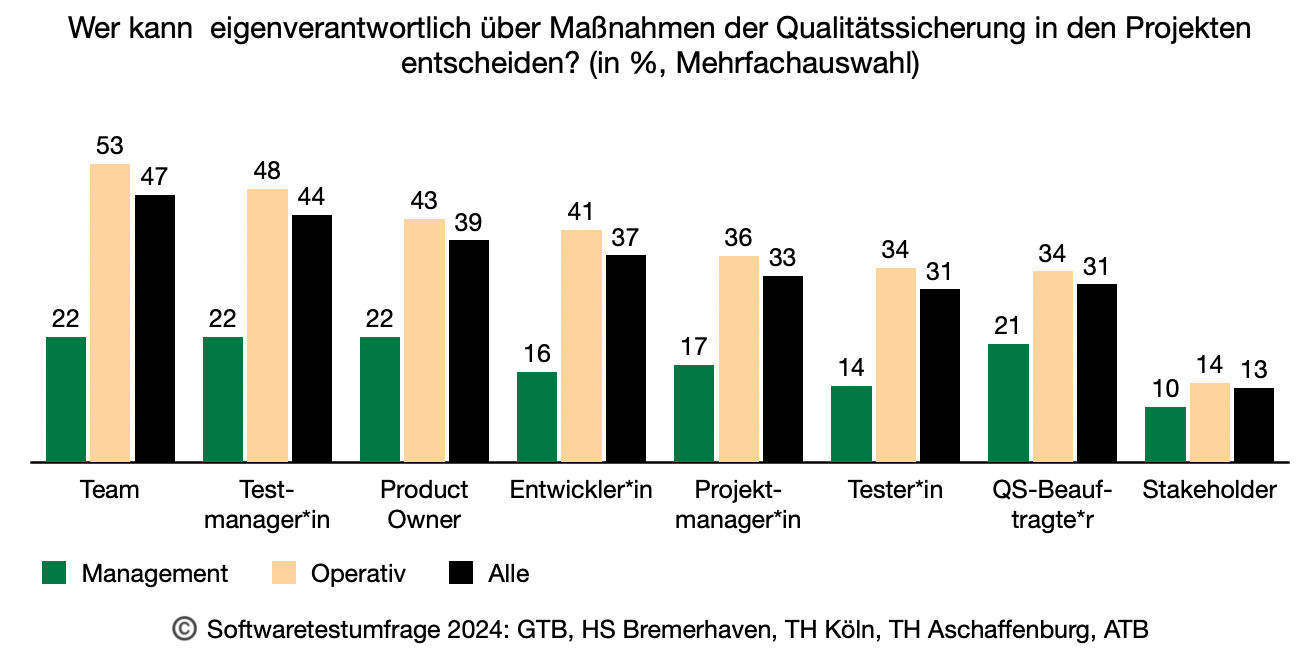

Eine noch deutlichere Diskrepanz zwischen den beiden befragten Gruppen zeigt sich bei der Frage, wer in einem Projekt eigenverantwortlich über Maßnahmen der Qualitätssicherung entscheiden kann (Abb. 2). Während die operativ Tätigen hier einen klaren Schwerpunkt mit 53% auf das Team legen, sehen nur 22% aus dem Management dort diese Entscheidungskompetenz. Beide Gruppen zeigen allerdings auch noch eindeutige Altlasten älterer Vorgehensmodelle: So entscheiden laut Angaben aller Teilnehmenden häufig die Projektmanager:innen (33%), die QS-Beauftragten (32%) oder sogar ganz allgemein die Stakeholder (13%) über die Maßnahmen der Qualitätssicherung. Diesen Antworten steht das Paradigma der Selbstorganisation agiler Teams entgegen, was den hohen Anteil hybrider Ansätze zu erklären scheint.

Abb. 2: Verantwortlichkeiten

Auffällig ist zudem, dass das Management bei der Möglichkeit der Mehrfachnennung dazu neigt, die Verantwortlichkeit einigen wenigen Rollen (im Durchschnitt 1,5 Rollen) zuzuordnen, wohingegen die operativ Tätigen gerne mehrere Rollen gleichzeitig auswählen (durchschnittlich mehr als 4 Rollen). Hier zeigt sich vermutlich der klare Wunsch des Managements, einen oder einige wenige Ansprechpersonen zu haben.

KI im Testen hat bereits klare Schwerpunkte

Wie bereits die letzte Softwaretest-Umfrage 2020 zeigte, ist die Auslagerung von Aufgaben an externe Dienstleister, die Anfang des Jahrtausends einsetzte, rückläufig. Aus Sicht des Managements werden folgende Tätigkeiten – wenn auch im geringen Umfang - delegiert: Testautomatisierung (23%), Codierung (21%), Erzeugung von Testfällen (16%) und Erzeugung von Testdaten (13%). Diese Tätigkeiten werden auch von den operativ Tätigen für eine mögliche Delegation aufgeführt, durchschnittlich aber deutlich seltener.

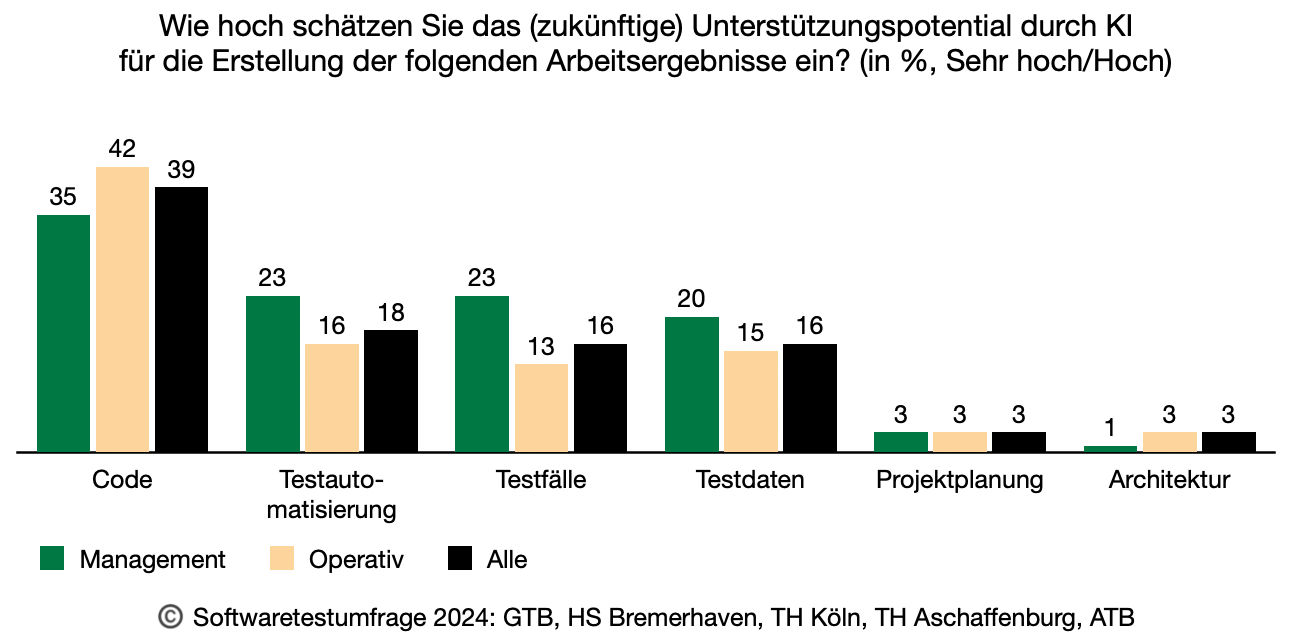

Die Delegation wird für diese Tätigkeiten der KI übertragen. So geben bereits heute 35% der Teilnehmenden aus dem Management an, dass KI bei der Codierung verwendet wird (Abb. 3). Dass diese Frage von 42% der operativ Tätigen im Bereich des Codierens positiv beantwortet wird, zeigt, dass nicht jede KI-Nutzung bei der Codierung im Management bekannt zu sein scheint. Auf der anderen Seite sieht das Management mehr KI im Einsatz, als dies die operativ Tätigen sehen: so im Bereich der Testautomatisierung (23% vs. 16%), der Testdaten (20% vs. 15%) und der Testfälle (23% vs. 13%).

Abb. 3: Einsatz von Künstlicher Intelligenz (KI)

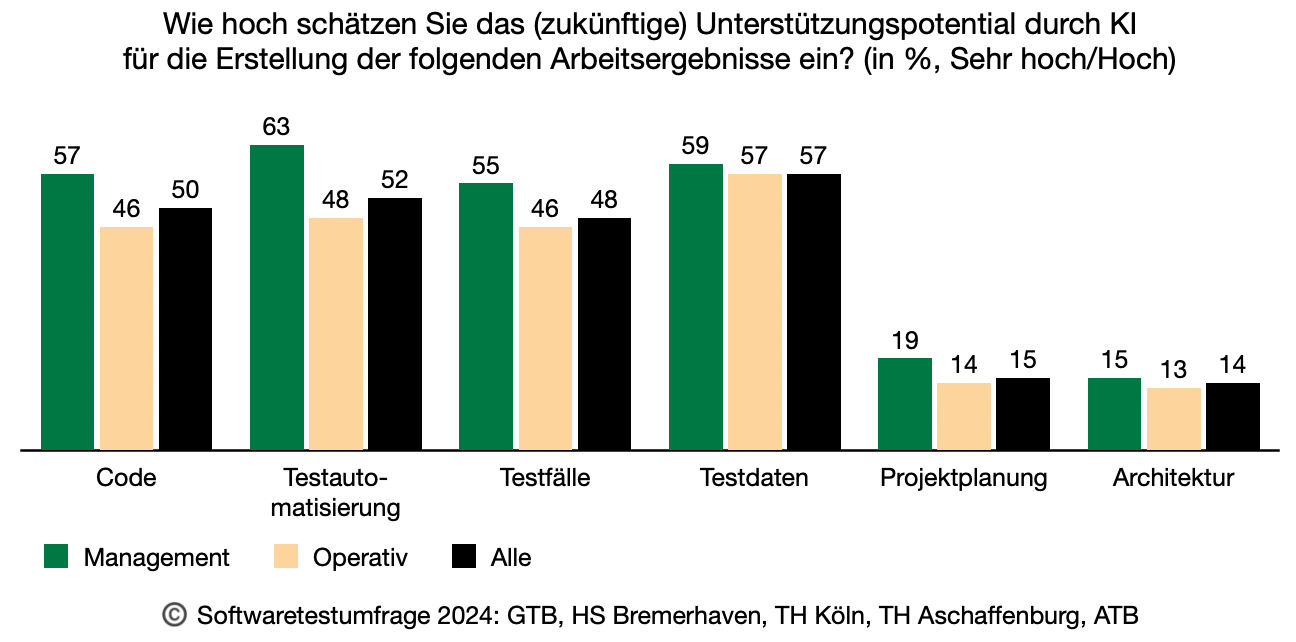

Trotz Unterschiede zwischen den befragten Gruppen wird insgesamt das Potential von KI zur Unterstützung einiger Bereiche als sehr hoch angesehen (Abb. 4). 57% aus dem Management sehen demnach ein hohes Potential im Bereich des Codierens (Operativ Tätige 46%), 63% für die Testautomatisierung (vs. 48%) und 59% für die Erzeugung von Testdaten (vs. 57%). Schlusslicht sind hier Aufgaben der Projektplanung (19% vs. 14%) und Architektur (13% vs. 15%). Eine weitere Diskrepanz zwischen beiden Gruppen der Befragten zeigt sich in der Einschätzung, wie hoch der Weiterbildungsbedarf im Bereich Testen mit KI gesehen wird: Sehen hier fast dreiviertel der operativ Tätigen großen Weiterbildungsbedarf, so hält dies nur jeder Fünfte aus dem Management für erforderlich. Beide Gruppen sehen sich und das umgebende Unternehmen heute allerdings gleichermaßen gut für die Zukunft bzgl. künstlicher Intelligenz aufgestellt: 23% zeichnen hier sogar ein sehr positives Bild.

Abb. 4: Potential von Künstlicher Intelligenz (KI)

Herausforderungen bleiben in den Bereichen Performanz, IT-Sicherheit und Testautomatisierung

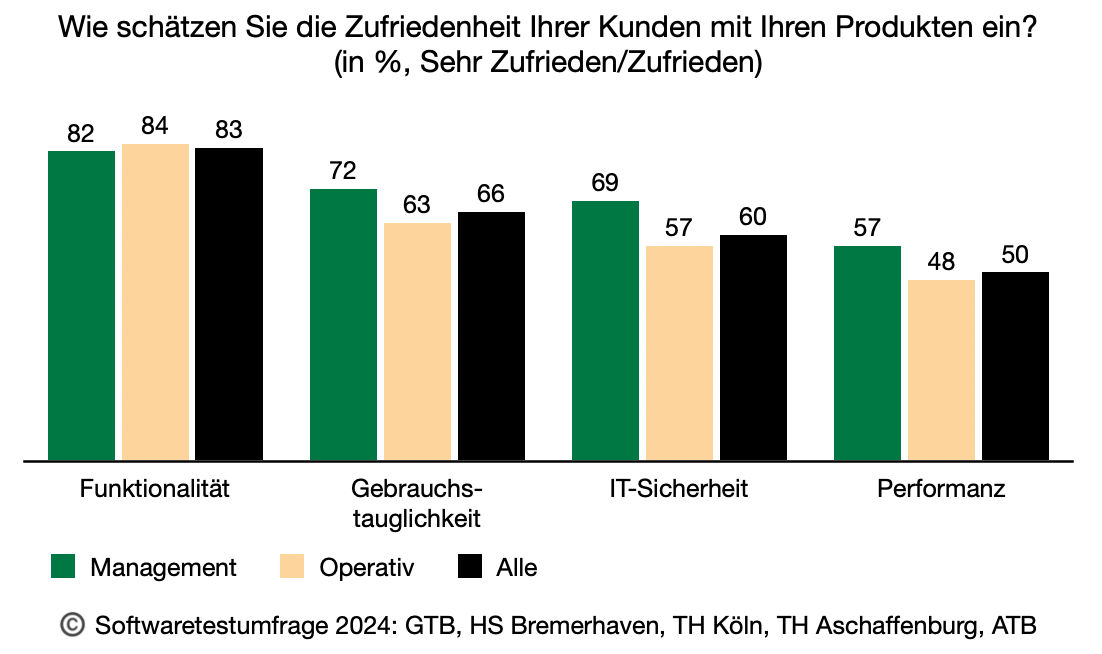

Alle Teilnehmenden bestätigen, dass die Kunden mit der Funktionalität zufrieden sind (mehr als 81%). Auch die Effektivität des Testens erhält für die Funktionalitätstests Bestnoten: Mehr als 82% aller Befragten bewerten diese mit hoch oder sogar sehr hoch. Schlusslicht ist hier die Performanz: Nur 49% des Managements und sogar nur 30% der operativ Tätigen schätzen die Effektivität der Last- und Performanztests als hoch oder sehr hoch ein. Im Bereich der IT-Sicherheitstests sieht die Einschätzung nicht besser aus. Auch hier wird der Status-Quo im Kreise der operativ Tätigen deutlich negativer (nur 31% hoch oder sehr hoch) eingeschätzt, als vom Management (48%). Diese Qualitätskriterien sind dann auch genau diejenigen, die entlang der Analyseergebnisse beim Kunden laut aller Teilnehmenden seltener mit zufrieden angegeben werden (Abb. 5): IT-Sicherheit: 60%, Performanz: 50%. Hier muss die Testeffektivität in den nächsten Jahre noch gesteigert werden, um die Kunden auch bei diesen Qualitätskriterien zu überzeugen.

Abb. 5: Zufriedenheit der Kunden

Der Bereich Testautomatisierung scheint zu stagnieren. Aktuell haben nur knapp 51% der operativ Tätigen einen vollständig automatisierten Komponententest. 8% geben sogar an, diesen vollständig manuell durchzuführen. Die Automatisierung im Systemtest wird mit 10% angegeben: Hier gehört viel manuelle Arbeit noch zum Testalltag.

Noch spannender sind die Zahlen beim Regressionstest: Selbst dieser, ein per Definition sich wiederholender Test, ist mit nur knappen 29% vollständig automatisiert; 12% geben an, den Regressionstest vollständig manuell durchzuführen. Wenn zusätzlich Last- und Performanztests berücksichtigt werden, wird es noch dünner, denn diese sind laut Angaben der operativ Tätigen erst zu 26% automatisiert. 25% geben tatsächlich an, die Last- und Performanztests – wie auch immer – vollständig manuell durchzuführen. Bestätigt wird der Eindruck durch die identifizierten Herausforderungen für Testumgebungen. 64% der operativ Tätigen nennen Probleme in der Bereitstellung einer Testumgebungen für spezielle Qualitätsmerkmale (Performanz, IT-Sicherheit, …), 70% erachten die Erzeugung und Bereitstellung von Testdaten als schwierig. 58% sehen die Produktionsnähe als nicht gegeben. Positiv stimmt hier nur, dass die operativ Tätigen in der Testautomatisierung einen großen Weiterbildungsbedarf sehen (54%). Das Management fühlt sich hier besser aufgestellt: In diesem Bereich sehen nur 19% einen Weiterbildungsbedarf.

Vorläufiges Fazit

Die ersten Analysen zeigen, dass sich die Trends der letzten Jahre im Bereich der Qualitätssicherung von Software und Systemen fortschreiben lassen. Die Qualitätssicherung der Funktionalität scheint etabliert, während nicht-funktionale Qualitätskriterien wie z.B. IT-Sicherheit und Performanz weiterhin einen Nachholbedarf haben. Obwohl im Rahmen von CI/CD-Pipelines viel über Testautomatisierung diskutiert wird und ausreichend Werkzeuge zur Verfügung stehen, schreitet die Umsetzung der Testautomatisierung auf allen Teststufen und zu den verschiedenen Testarten überraschend langsam voran. Mit dem Einsatz von KI lassen sich erste neue Trends beobachten. Ob diese sich etablieren wird sich in Zukunft zeigen.

Weitere Ergebnisse zur Umfrage Softwaretest in Praxis und Forschung stehen auf der Seite softwaretest-umfrage.de zur Verfügung.

weitere Autorin des Artikels:

(Quelle Aufmacherbild: https://www.canva.com/)