Schon in der Einleitung gab Google die Parole Making AI Helpful for Everyone aus, ein Trend, der sich auch im Rest der Vorträge fortsetzt.

In hauseigenen Diensten sprach Google davon, dass die KI-getriebenen Hilfs-Services im letzten Jahr mehr als 180 Milliarden Mal eingesetzt werden – darunter versteht Google beispielsweise die "Smart Reply"-Funktion, die Gmail-Nutzern beim Verfassen von Antworten auf E-Mails unter die Arme greift. In diesem Bereich versprach Google eine Erweiterung der Modelle, was in Zukunft zu noch intelligenteren Autovervollständigungsvorschlägen führen dürfte. Der Illustration diente ein automatischer Antwort-Assistent, der im Rahmen der Keynote einen automatischen Geld-Rückforderungs-Antrag an eine Fluglinie verfasste.

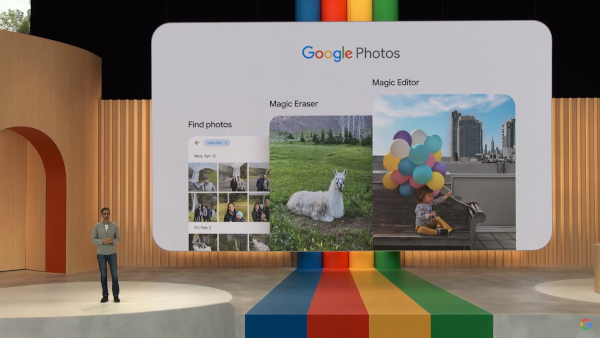

Auch sonst stehen verschiedene KI-getriebene „Erweiterungen“ für das Google-Portfolio ante portas. Abbildung 1 zeigt beispielsweise den "Magic Editor", der verschiedenste Bilder "automatisiert" verbessert.

Im Hintergrund kommt dabei ein neues Modell zum Einsatz, das von Google als PaLM 2 bezeichnet wird – Ähnlichkeiten zum Betriebssystem-Klassiker Palm OS sind naturgemäß rein zufällig. Interessant ist an PaLM vor allem, dass es in vier Ausbaustufen angeboten wird: Gecko, Otter, Bison und Unicorn. Die kleinste Variante, der Gecko, ist explizit auch für den Einsatz am Handy vorgesehen.

Im Laufe der nächsten Jahre wird Google – logischerweise – die verschiedensten Dienste auf PaLM 2 umstellen. Das laut der Vorführung zu mehr als 100 Sprachen „kompatible“ System dürfte ob seines tieferen Trainings-Datensatzes in vielen Einsatzszenarien teilweise wesentlich bessere Ergebnisse erzielen.

Angemerkt sei außerdem, dass "viele" der in PaLM 2 möglichen AI-Payloads auch in der Google Cloud exponiert werden, wo sie für Drittanbieter ansprechbar sind. Im Rahmen der Keynote erwähnte Google beispielsweise die Deutsche Bank und die amerikanische Fastfood-Kette Wendys als "Referenzkunden". Besonders interessant ist in diesem Zusammenhang auch das Spezial-KI-Modell Codey. Es lässt sich (analog zum GitHub-Copilot) gegen eine hauseigene Codebasis trainieren und nutzt die daraus gewonnenen Erkenntnisse dann für eine Bard-artige "sprachgesteuerte Codierung".

Abb. 1: Keynote von CEO Sundar Pichai. Das Ende der Fotografie?

Ökosystem-Play mit Android

Der Wert eines "geräteumspannenden"“ Ökosystems ist Google offensichtlich bewusst. Die erste Erwähnung des hauseigenen Mobilcomputer-Betriebssystems erfolgte deshalb in der Haupt-Keynote, und lief unter dem Titel Android: Ökosystem. Auch hier begannen die Vorträge damit, verschiedene Möglichkeiten zur Nutzung von KI-Arten in Android zu erwähnen. Besonderen Applaus von Seiten der Zuhörerschaft erhielt ein Verfahren, das Spam-Anrufe und Spam-SMS unter Nutzung verschiedener KI-Prozesse (lies: nicht nur bayesianischer Filter) zu erkennen und als gefährlich zu markieren sucht.

Besonders hervorgehoben wurde das rapide Wachstum im Bereich Android Wear um den Faktor 5. Ein nativer WhatsApp-Client wurde übrigens für den Sommer angekündigt.

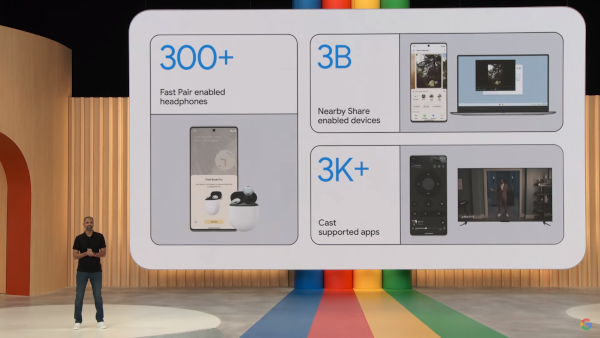

Das "Zusammen-Bringen" der verschiedenen Geräte erweist sich dabei insbesondere für technisch herausgeforderte Nutzer als haarige Aufgabe – Abbildung 2 zeigt drei Systeme, die sich um die Verbindung innerhalb des Ökosystems kümmern.

Abb. 2: Sozial und gut verbunden: Das Android-Ökosystem (mit tatkräftiger Mithilfe der Entwicklergemeinschaft)

Wohl als Antwort auf Apples (universell kontroversielles) Air-Tags-System führt Google Find My Device ein. Dabei handelt es sich um ein "analog" gebautes System, das aber statt iOS-Geräten auf Android-Hardware setzt. "Anfangs-Use-Case" ist dabei das Lokalisieren von vergessenen oder angebauten Tablets, Headphones und Co. Im Rahmen der Keynote sprach man allerdings explizit auch davon, in nicht allzu ferner Zukunft eher Tag-artige Analogons anzubieten, die aber im Google-Netzwerk Find My Device arbeiten werden.

Im Interesse der Datensicherheit setzt Google logischerweise auf starke kryptografische Algorithmen, um die am "Einsammeln" der Informationen beteiligten Geräte nicht mehr als notwendig über das gefundene Objekt zu informieren. Mit Unknown Tracker Alerts sollen Android-Smartphones außerdem die Möglichkeit bekommen, das "Mitführen" von Airtag und Co. zu lokalisieren. Auf diese Art und Weise lässt sich ein von einem Angreifer "platziertes" Tag über kurz oder lang identifizieren. In diesem Bereich einigte man sich außerdem mit Apple, weshalb die Funktion auch mit iOS-Hardware funktionieren sollte.

Naturgemäß gab es auch Ankündigungen neuer Hardware: Das Pixel 7A ist eine neue Variante des Smartphones Pixel 7, das auf dem Google-G2-Prozessor basiert. Auch hat es eine neue Kamera, die einen 72 Prozent größeren Sensor aufweist – "Sinn" davon, ist dass das ab 499 US-Dollar erhältliche Telefon weniger „rauschende“ Bilder liefert.

Interessanter ist das Pixel Tablet, die „Google-Version“ des Produkts, das laut Aussage auf der Keynote im Allgemeinen seit zehn Jahren „fast unverändert gebaut wird“. Als wichtigstes Problem in der praktischen Tablet-Nutzung hat Google dabei – interessanterweise – leere Akkus auserkoren, ein Problem, dem man durch ein Lade-Dock Abhilfe zu schaffen sucht.

Außerdem werden Tablets als „soziale“ Geräte wahrgenommen, ein Trend, dem man durch konsequente Umsetzung der in Android an sich seit längerer Zeit verfügbaren Mehrbenutzer-Verwaltung Rechnung zu tragen sucht. Zu guter Letzt sorgt ein integrierter ChromeCast-Transceiver dafür, dass auf dem Tablet befindliche Multimedia-Inhalte bequem „sozial genutzt“ werden können.

Zumindest während der Vorbestell-Phase gilt außerdem, dass das – je nach Speicherausbau – ab 499 US-Dollar erhältliche Gerät prinzipiell und immer mit dem Lade-Lautsprecher-Dock verkauft wird.

Im Bereich der Mobilcomputer gibt es außerdem das Pixel Fold, ein „klappbares“ Telefon, das analog zum Samsung Fold in all seinen Varianten sowohl als Tablet als auch als klassisches Smartphone verwendet werden kann. Innovativ ist der Dual Screen Interpreter Mode, bei dem der Innen- und der Außenbildschirm gleichzeitig benutzt werden. Auf diese Art und Weise können die „erzeugten“ Überzeugungen einer Person angezeigt werden, während die gegenüberstehende Person ihre native Sprache spricht.

Schade ist lediglich der hohe Preis, das Produkt beginnt bei 1799 USD. Wer eine Vorbestellung „subskribiert“, bekommt allerdings Googles Smartwatch „kostenlos dazu“.

Werkzeuge für Entwickler ...

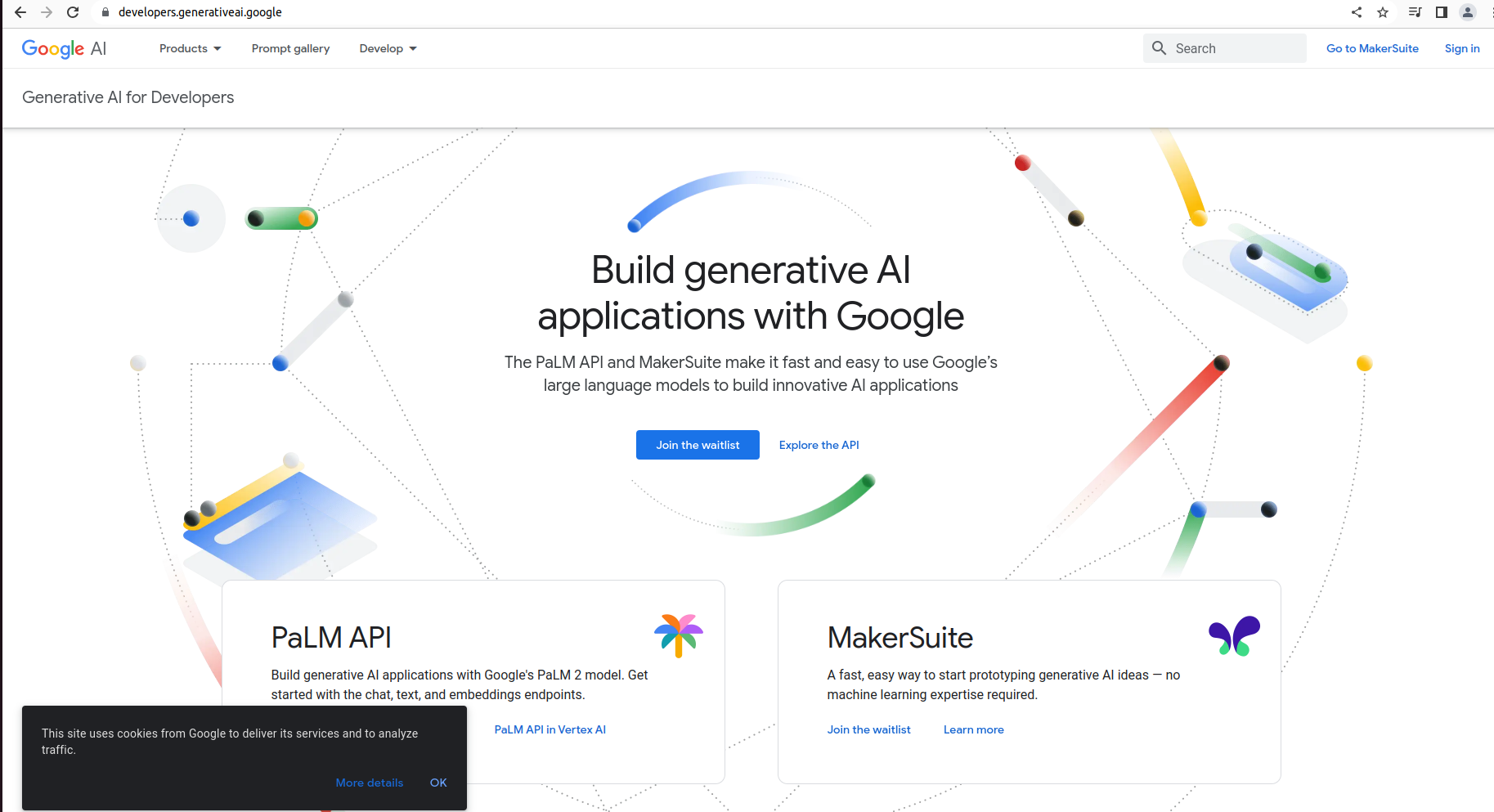

Aus der „KI-Fokussierung“ des Kongresses als Ganzes folgt, dass die PaLM-Services am „Beginn“ der Entwickler-Vorträge standen. Wer möchte, kann sich unter G.CO\PaLM anmelden, um die in Abbildung 3 gezeigte PaLM-Startseite zu sehen (https://developers.generativeai.google/).

Abb. 3: Dieses Portal führt Entwickler in die „wilde weite Welt“ von Googles AI-APIs

In Android Studio Hedgehog steht mit Android Studio Bot eine dedizierte Künstliche Intelligenz zur Verfügung, die sich um die Optimierung von vorliegendem Code kümmert. Der Sprecher präsentierte die Funktion unter anderem im Rahmen der „Erweiterung” einer nativen Applikation um eine Tablet-Komponente.

Nokias antiker RDP-Dienst kehrt in Form von Physical Device Streaming zurück: Pixel-Fold- und Pixel-Tablet-Geräte in einer Serverfarm von Google lassen sich so mit Software beladen, was dem Entwickler die direkte Interaktion mit diesen (immer noch nicht unbegrenzt verbreiteten) Formfaktoren erlaubt.

Wegen des schnellen Wachstums der Plattform Android Wear erweitert Google die Watchface-API. Neu ist erstens ein rein XML-basiertes Watchface-Format, das unter [Ber23] dokumentiert ist und ab sofort zur Realisierung der Watchface-Applikationen herangezogen werden darf. Zweitens gibt es Erweiterungen im Bereich der Animationen für die in der Timeline angezeigten Tiles. Zu guter Letzt stehen mit Platform Data Sources neue Data-Binding-Ziele zur Verfügung – sie exponieren verschiedene Daten des zugrunde liegenden Betriebssystems (z. B. Puls des Users).

Nutzer von Kotlin – Googles neue Programmiersprache wird angeblich in mehr als 90 Prozent der Top 1000-Applikationen verwendet – dürfen bald auf den JetBrains-K2-Compiler setzen: Er soll die Kompilation von Kotlin-Code wesentlich beschleunigen.

Bot im Test

Mehr Informationen zum Codierassistenten finden sich unter https://developer.android.com/studio/preview/studio-bot. Eine allgemeine Liste neuer Funktionen in Android Studio steht unter https://android-developers.googleblog.com/2023/05/androidstudio-io-23-announcing-studio-bot.html bereit.

... und die Quadratur des Kreises

Ein Vortragender bezeichnete das „Entweder-oder” zwischen Web-Applikation und nativer Applikation als „langweilige und wenig gewinnbringende” Debatte. Zur Überbrückung bietet Google ab sofort die Möglichkeit an, Kotlin-Code in WebAssembly-Runtimes auszuführen. Auf diese Art und Weise lässt sich noch mehr Code wiederverwenden, was mit den bekannten Verbesserungen im Bereich Softwarekoppelung und Co. einhergeht.

Mit WebGPU arbeitet Google außerdem an einer API, die Web-Applikationen den Zugriff auf die GPU des jeweiligen Browserclients gibt. Für TensorFlow JS verspricht Google dabei eine Performancesteigerung von bis zu 100 gegenüber JavaScript, WebGL ist um den Faktor drei langsamer.

Mindestens ebenso ein Kampf gegen Windmühlen ist die Aufgabe, Handcomputernutzer zum Bezahlen von Applikationen zu animieren. Auf der I/O präsentierte Google umfangreiche Erweiterungen für den Play Store, die neue Einnahmequellen öffnen. Erstens ist es bald möglich, im Play Store In-App-Produkte anzubieten: Wer ein „beliebtes” IP-Portfolio vertritt, kann so In-App-Items „direkt” aus dem Play Store vertreiben. Zweitens arbeitet Google daran, die Preisflexibilität zu erhöhen – eine Art AB-Testing, das das Testen von Preispunkten in verschiedenen Märkten erlaubt.

Außerdem erlaubt Google fortan noch mehr Varianten des Store-Listing-Texts, um beispielsweise „alte” User eines Produkts abermals zu reaktivieren. Weitere Informationen zu den neuen Möglichkeiten im Play Store finden sich unter [Mus23].

Elementspezifische Erweiterungen

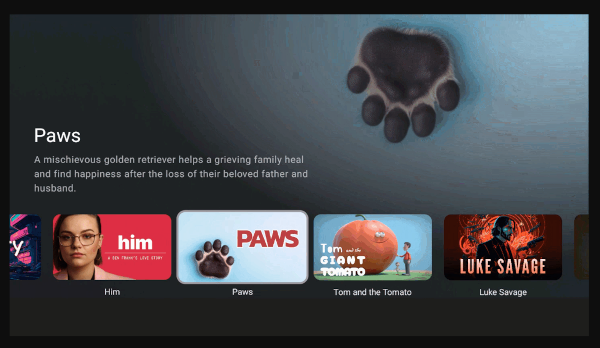

Google gibt den SmartTV-Markt nicht verloren: Mit Compose for TV lässt sich der als Teil der MAD-Entwicklungsumgebung promotete GUI-Stack fortan auch am Fernseher einsetzen. Google erleichtert Entwicklern die Erzeugung von in Multimedia-Applikationen häufig benötigten Ansichten – ein Beispiel ist das in Abbildung 4 gezeigte Content-Karussell, das durch das Snippet in Listing 1 realisierbar ist. Möchte man die in Abbildung 4 gezeigte Navigationsleiste wegfallen lassen, so präsentiert sich das Mark-up stattdessen wie in Listing 2.

ImmersiveList(

modifier = Modifier.height(130.dp).fillMaxWidth(),

background = { index, _ ->

AnimatedContent(targetState = index) {

MyImmersiveListBackground(it)

}

},

) {

TvLazyRow {

items(featuredContentList.size) { index ->

MyCard(

Modifier.focusableItem(index),

featuredContentList[index]

)

}

}

}

Abb. 4: Ähnlichkeiten zu Videostreaming-Apps sind rein zufällig (Bildquelle: Google)

Carousel(

itemCount = featuredContentList.size,

) { index ->

CarouselItem(

background = {

MyBackground(index)

},

content = {

MyFeaturedContent(featuredContentList[index])

}

)

}Unterm Strich ist jedenfalls festzuhalten, dass die Nutzung von Compose for TV das Zusammenstellen häufig benötigter Medienpräsentations-Widgets wesentlich erleichtert.

Wichtige Neuerung Numero zwei ist Health Connect: Das bisher nur als herunterladbare Drittanbieterkomponente zur Verfügung stehende System ist ab Android 14 fixe Betriebssystemkomponente. Wer dieses Interface zur Interaktion mit Gesundheitsdaten bisher nicht verwendet hat, findet unter https://github.com/android/health-samples einige schlüsselfertige Codebeispiele.

Android Auto erfuhr ebenfalls Erweiterungen: Es handelt sich dabei um einen „funktionseingeschränkten” GUI-Stack, der (wohl zwecks Vermeidung von Klagen) nur einige vorbestimmte GUI-Arten bzw. Masken anzeigen konnte. Auf der I/O kündigte Google Wetter- und IoT-Steuerungsschemata an. Im geparkten Zustand soll Android Auto fortan außerdem auch zur Ausführung von mehr oder weniger beliebigen Applikationen befähigt sein.

Zu guter Letzt sei noch auf Android 14 hingewiesen – es steht nun in einer zweiten Beta zur Verfügung, die wie unter https://android-developers.googleblog.com/2023/05/android-14-beta-2.html en détail beschrieben verschiedene Erweiterungen im Bereich der Kamera-Extensions mitbringt – dabei handelt es sich um „Plug-ins”, die sich in die Kameradatenpipeline integrieren und die Anpassung des Anzeigeverhaltens beeinflussen. Wichtig ist, dass derartige fortgeschrittene Pipelines nicht auf allen Telefonen zur Verfügung stehen – zur Suche bietet sich nach dem Schema in Listing 3 aufgebauter Code an.

private List getExtensionCameraIds(CameraManager cameraManager)

throws CameraAccessException {

if (Build.VERSION.SDK_INT >= Build.VERSION_CODES.S) {

return Arrays.stream(

cameraManager.getCameraIdList()).filter(cameraId -> {

try {

CameraCharacteristics characteristics =

cameraManager.getCameraCharacteristics(cameraId);

CameraExtensionCharacteristics extensionCharacteristics =

cameraManager.getCameraExtensionCharacteristics(cameraId);

IntStream capabilities =

Arrays.stream(

characteristics.get(

CameraCharacteristics.REQUEST_AVAILABLE_CAPABILITIES

)

);

return !extensionCharacteristics.getSupportedExtensions().isEmpty()

&& capabilities.anyMatch(

capability -> capability == CameraCharacteristics

.REQUEST_AVAILABLE_CAPABILITIES_BACKWARD_COMPATIBLE

);

} catch (CameraAccessException e) {

throw new RuntimeException(e);

}

}).collect(Collectors.toList());

} else {

return Collections.emptyList();

}

}Die neue Konstante MIXER_BEHAVIOR_BIT_PERFECT sorgt in AudioMixer-Attributes dann dafür, dass die angelieferten Daten eins zu eins von der Applikation zu einem USB-Audiogerät weiterwandern – laut der von Google gestellten Dokumentation ein Entgegenkommen an Audiophile, die ihre Android-Hardware in DAW-Workflows einbinden wollen.

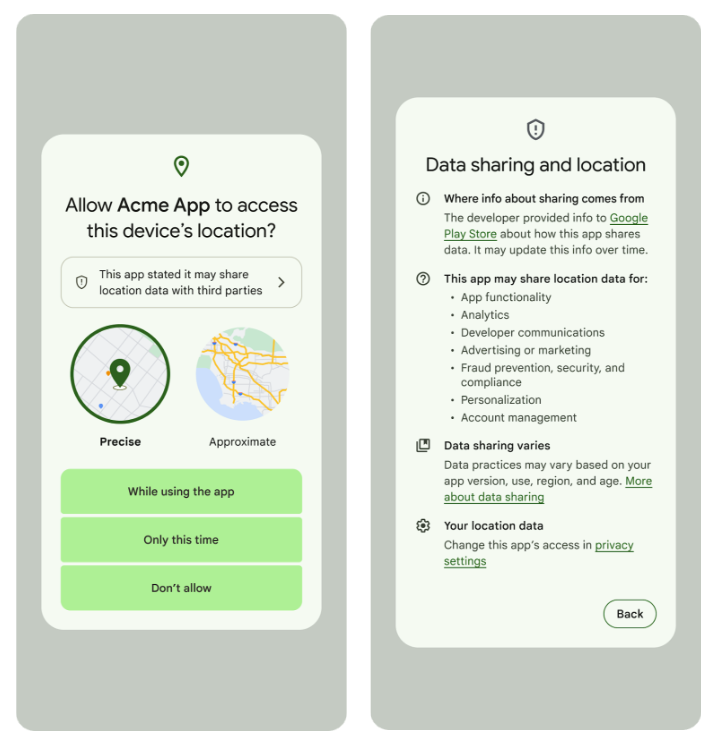

Googles im Play Store seit einiger Zeit verfügbares Data-Safety-Formular kommt in Android 14 ebenfalls zu neuen Ehren. Abbildung 5 zeigt, dass der Permission-Dialog die in dem Formular hinterlegten Daten zur Laufzeit anzeigt.

Abb. 5: Das Data-Safety-Formular im praktischen Einsatz

Fazit

Google ist sich der Mächtigkeit von „Allandroid” durchaus bewusst: Das Unternehmen arbeitet permanent daran, Entwicklern das Leben zu erleichtern. Auf dieser I/O kündigte Big G nichts an, was das Leben verschlechtert – unterm Strich eine positive Erfahrung.

Weitere Informationen

[Ber23] A. Bernbaum, 10.5.2023,

https://android-developers.googleblog.com/2023/05/introducing-watch-face-formatfor-wear-os.html

[Mus23] A. Musil, 10.5.2023,

https://android-developers.googleblog.com/2023/05/io-2023-whats-new-in-google-play.html