Spätestens mit dem Start von ChatGPT Ende 2022 ist Künstliche Intelligenz (KI) im Allgemeinen, vor allem aber Generative AI im Speziellen auf unserer Landkarte aufgetaucht. Auch wenn das Thema erst damit in der Breite wahrgenommen wird, ist es natürlich nicht neu und wird seit Jahrzehnten erforscht und entwickelt. Die wesentliche Neuerung ist aber, dass KI jetzt allgemein verfügbar und vor allem benutzbar und zugänglich ist. Damit ist KI jetzt wirklich da, die Entwicklungen sind exponentiell und wir können nur erahnen, wo die Reise hinführen wird. In jedem Fall ist es aber das, was wir typischerweise als Disruption bezeichnen – auch die Softwareentwicklung hat sich schon stark verändert und wird es noch viel stärker tun in den kommenden Jahren.

Die Bedeutung von KI für Softwaretesten

Diese Disruption betrifft auch unsere Disziplin – das Softwaretesten. Nachdem wir mit dem Start von ChatGPT euphorisch auf die neuen Möglichkeiten und damit verbundenen Chancen geschaut haben, erkennen wir nun immer stärker, welche (tatsächlichen und potenziellen) Auswirkungen KI auf unser Berufsbild haben wird und dass es durchaus auch berechtigte Zweifel und Risiken gibt.

Das Testen wird durch KI im Wesentlichen in zwei Bereichen beeinflusst:

Testen von KI: Unser Portfolio an Testobjekten erweitert sich um völlig neuartige Vertreter: Neben den „klassischen“ Systemen haben wir es jetzt auch mit KI-Systemen zu tun, deren Qualität bewertet werden sollte. Zum einen können das eigenständige KI-Systeme sein, zum anderen – und dies wird viel häufiger der Fall sein – können das KI-basierte Systeme oder Komponenten sein, welche mit klassischen Systemen oder Komponenten integriert werden. Somit wird KI-Technologie Einfluss auf Gesamtsysteme und Ende-zu-Ende-Prozesse haben. Da sich KI-Systeme anders verhalten, als wir es von klassischen Systemen gewohnt sind (u.a. sind sie nicht-deterministisch und ihr Verhalten ist probabilistisch), müssen wir hierfür unsere Testverfahren anpassen beziehungsweise neue Testverfahren verwenden.

Testen mit KI: Die KI ist aber nicht nur ein Testobjekt, sie ist auch ein Testmittel. Testaktivitäten können durch KI teilweise unterstützt oder vielleicht sogar vollständig abgebildet werden. Die bislang rein menschliche Tätigkeit des Testens wird sich dadurch verändern und zukünftig im Zusammenspiel von Menschen und (intelligenten) Maschinen erfolgen.

Was ist die Herausforderung?

Wenn man einen Menschen fragt, was die wichtigste Fähigkeit eines Softwaretesters ist, kann es nur eine Antwort geben. Stellt man ihm die Frage erneut, sollte er dieselbe Antwort geben (zumindest, wenn die Frage direkt wiederholt wird und sich in dieser kurzen Zeitspanne die Welt der Tester-Skills nicht fundamental verändert hat), zum Beispiel „Genauigkeit“.

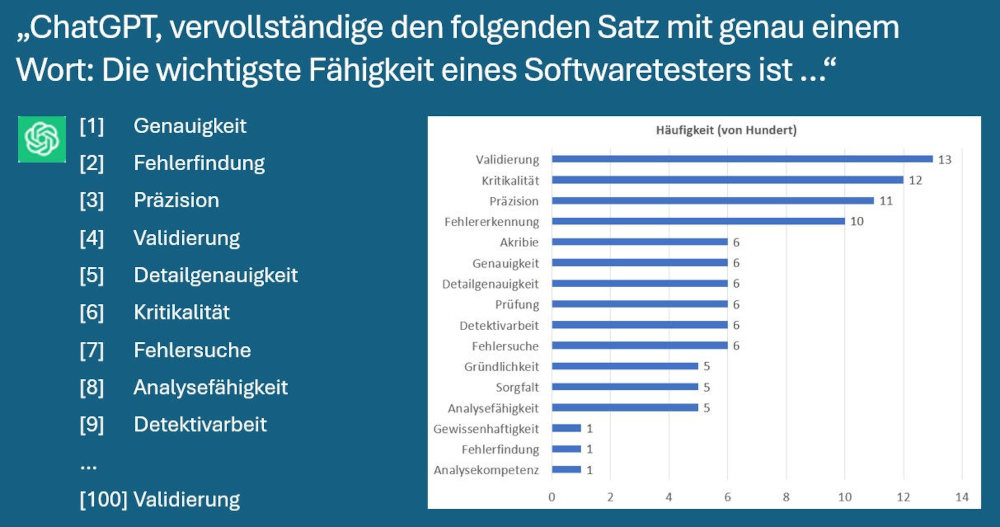

Stelle ich nun ChatGPT diese Frage, erhalte ich ebenfalls eine Antwort. Stelle ich die Frage ein zweites Mal, erhalte ich möglicherweise eine andere Antwort, beim dritten Mal ebenso, und so weiter. Ich habe ChatGPT die Frage einhundert Mal gestellt und insgesamt 16 verschiedene Antworten erhalten (siehe Abb. 1). Dieses Verhalten ist nun anders, als wir es von einem Menschen erwarten würden – auf die Frage nach „Was ist das wichtigste …“ kann es ja eigentlich nur genau eine Antwort geben.

Abb. 1: Antworten von ChatGPT auf die Frage nach der wichtigsten Fähigkeit eines Softwaretesters und Häufigkeit der Antworten bei einhundert Wiederholungen

Arbeiten wir nun mit KI, müssen wir mit einem solchen Verhalten umgehen, sei es, weil wir eine KI testen oder weil wir eine KI nutzen, um Testmittel zu generieren. Wenn wir beispielsweise ein Sprachmodell wie ChatGPT nutzen, um Testdaten zu generieren, stellt sich uns die Frage, inwieweit die Ergebnisse valide sind und wir diesen tatsächlich vertrauen können. Wir müssen die Ergebnisse hinterfragen und erkennen können, sobald es sich nicht um valide Ergebnisse handelt.

Mensch vs. KI im Testen

Beide Bereiche – Testen von KI und Testen mit KI – werden das Berufsbild des Testens massiv beeinflussen und erfordern die passenden Skills von Testerinnen und Testern. Beim Testen mit KI stellt sich perspektivisch dann die Frage, in welchem Umfang die KI das Testen übernehmen kann und soll und welchen Bedarf es noch nach Menschen geben wird.

Dieser Frage möchte ich im Folgenden weiter nachgehen und dafür zwei Thesen weiter beleuchten:

- KI als Assistent: Der primäre Nutzen von KI im Testen liegt in der Effizienzsteigerung von Testaktivitäten und nicht darin, Menschen zu ersetzen.

- Human-in-the-Loop: Für die Qualitätsbewertung von KI brauchen wir den Menschen zwingend, wir können und dürfen den Menschen gar nicht ersetzen.

Höhere Effizienz im Testen

KI kann viele Aufgaben beim Testen übernehmen

KI kann schon heute viele Testaktivitäten in unterschiedlichem Umfang übernehmen, insbesondere dort, wo es sich um wiederholbare, leicht zu automatisierende und generative Tätigkeiten handelt oder auch um textintensive Tätigkeiten, bei denen große Mengen von Text analysiert und ausgewertet werden. Alle Aktivitäten im Testprozess können damit durch KI unterstützt werden, zum Beispiel:

- Anforderungen analysieren und Akzeptanzkriterien identifizieren,

- Testideen entwickeln und Testfälle generieren,

- Testskripte generieren und transformieren,

- Testdaten generieren,

- Testportfolio analysieren, priorisieren und optimieren,

- Testergebnisse analysieren und Muster erkennen,

- Fehler auswerten und klassifizieren.

Durch die Hilfe von KI starten wir unsere Aufgaben nicht bei null. Die KI kann leicht 80 Prozent der Vorarbeiten übernehmen, der Mensch muss sich „nur“ noch um die restlichen 20 Prozent kümmern. Insgesamt lassen sich Testaufgaben damit wesentlich effizienter und schneller durchführen – wir müssen weniger menschliche Arbeit investieren, um ein Problem zu lösen.

Die KI entbindet uns damit aber nicht davon, gut ausgebildete und erfahrene Tester zu sein. Für die 20 Prozent der Restarbeiten müssen wir unser Testhandwerk beherrschen und benötigen die richtigen Fähigkeiten, um die Qualität der 80 Prozent der Vorarbeiten einschätzen, bewerten und gegebenenfalls überarbeiten zu können. Hier zeigt sich schon, dass die größere Gefahr für menschliche Tester nicht die KI an sich ist, sondern andere Menschen, die besser testen können und wissen, mit KI umzugehen.

Effizienzsteigerungen führen zu höherem Ressourcenbedarf

Der Einsatz von KI ermöglicht es also, bei der Durchführung von Testaktivitäten Ressourcen zu sparen (menschliche Arbeit). Wir benötigen also weniger Menschen für die Durchführung derselben Aufgaben. Würden wir es bei derselben Menge von Aufgaben belassen, bräuchten wir perspektivisch in der Tat weniger Menschen. Wir werden die durch die Effizienzsteigerung gewonnenen Ressourcen jedoch wieder investieren, um mehr Aufgaben durchführen zu können – die Effizienzsteigerung führt also zu höherem Ressourcenbedarf.

In der Ökonomie ist dies als „Jevons-Paradoxon“ (und im erweiterten Sinn auch als „Rebound-Effekt“ bekannt): William Stanley Jevons stellte 1865 fest, dass Englands Kohlenverbrauch nach der Einführung von James Watts kohlebefeuerter Dampfmaschine anstieg, obwohl sie sehr viel effizienter war als Thomas Newcomens frühere Variante. Watts Neuerungen machten aus Kohle eine kostengünstigere Energiequelle und führten zu einer steigenden Verbreitung seiner Dampfmaschine im Verkehrsbereich und anderen Industriebereichen. Dies führte zu dem insgesamt erhöhten Kohlenverbrauch, obwohl zugleich der spezifische Verbrauch jeder einzelnen Anwendung nachließ (vgl. de.wikipedia.org/wiki/Jevons-Paradoxon).

Dieser Effekt lässt sich in sehr vielen Bereichen häufig beobachten, beispielsweise führt eine schnellere Verbindung zwischen Stadt A und Stadt B beim Reisen mit der Bahn zu einer erhöhten Nutzung dieser Verbindung. Aber auch in unserer Disziplin ist dieser Effekt bekannt, Beispiel Testautomatisierung: Testautomatisierung soll den Aufwand für wiederholte manuelle Tests reduzieren, die erwartete Einsparung ist häufig eine Reduktion von manuellem Testaufwand sowie schnellere Tests und effizientere Testprozesse. Obwohl die Automatisierung die Effizienz der Testdurchführung steigert, kann der erhöhte Bedarf an menschlicher Arbeit in Form von Skripterstellung, Wartung, Training und ergänzenden Tests dazu führen, dass insgesamt mehr Ressourcen (insbesondere Zeit und Personal) benötigt werden.

Beim Einsatz von KI im Testen liegt die Annahme also nahe, dass wir vergleichbare Effekte in Bezug auf menschliche Arbeit sehen werden. Der Effizienzgewinn wird zu schnellerem oder häufigerem Testen führen, menschliche Tester können sich mehr auf die Dinge konzentrieren, die sie besser können als die Maschine. Der Personalbedarf wird nicht reduziert.

Effizienzsteigerungen im Testen führen zu höherer Produktivität in der Softwareentwicklung

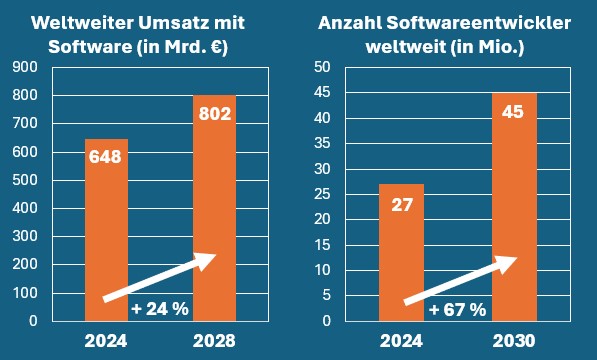

Der Trend in der Softwareentwicklung über die letzten Jahrzehnte ist, dass wir in immer kürzeren Zyklen immer mehr Software produzieren (siehe Abb. 2). Dies wird nicht zuletzt durch höhere Effizienzen im Testen ermöglicht – Automatisierung und Shift-Left-Ansätze sind wesentliche Grundpfeiler effizienter Softwareentwicklung. Die Effizienzsteigerungen im Testen durch KI werden also dabei helfen, Entwicklungszyklen weiter zu verkürzen und damit mehr Software in kürzerer Zeit zu produzieren. Der Bedarf an Menschen wird sich dabei nicht reduzieren.

Abb. 2: Weltweite Trends bei der Umsatzentwicklung mit Software und dem Bedarf nach Softwareentwicklern (Quelle: de.statista.com/outlook/tmo/software/weltweit)

Daneben ermöglicht uns der Einsatz von KI im Testen, Dinge zu tun, die wir andernfalls gar nicht machen würden, da dem Nutzen ein sehr hoher manueller Aufwand gegenüberstehen würde. Ein Beispiel: Wir haben ein sehr großes Portfolio aus automatisierten Tests mittels Selenium, möchten nun aber ein neues Testautomatisierungs-Framework einsetzen, zum Beispiel Playwright. Der manuelle Aufwand der Migration der Testskripte von Selenium zu Playwright ist sehr hoch und kann viele Ressourcen binden, die an anderer Stelle dringender benötigt werden. Mithilfe KI lässt sich eine solche Migration deutlich effizienter gestalten beziehungsweise macht diese erst möglich.

KI kann helfen, dass Testen kein Bottleneck mehr ist

Bevor wir uns überlegen, wen wir durch KI ersetzen könnten, schauen wir uns an, wo wir heute stehen. Wir haben häufig zwei Herausforderungen im Testen, bei denen KI uns helfen kann, erst mal unserer eigentlichen Pflicht nachzukommen (die Effektivität zu steigern), bevor wir überhaupt an Effizienzsteigerungen denken:

- Wir haben seit Jahren einen hohen Fachkräftemangel in unserer Disziplin und die Trends deuten auch nicht daraufhin, dass sich dies in absehbarer Zeit ändern wird. Aufgaben, die nicht durch Menschen besetzt werden können, da sie schlicht nicht da sind, können möglicherweise durch KI unterstützt oder übernommen werden und damit kann der Fachkräftemangel etwas gelindert werden.

- In vielen Organisation oder Projekten ist Testen weiterhin ein Bottleneck, sei es, weil die Entwicklungs- und Testprozesse unreif sind oder schlicht zu wenig Ressourcen (Zeit, Budget und Personal) zur Verfügung gestellt werden. Oft schaffen wir es nur mit großen Anstrengungen, ein angestrebtes Qualitätsniveau tatsächlich zu erreichen. KI kann hierbei helfen, überhaupt erst mal unserer Pflicht nachzukommen und ein Mindestmaß an Überdeckung zu erreichen.

Der Mensch kann und darf nicht ersetzt werden

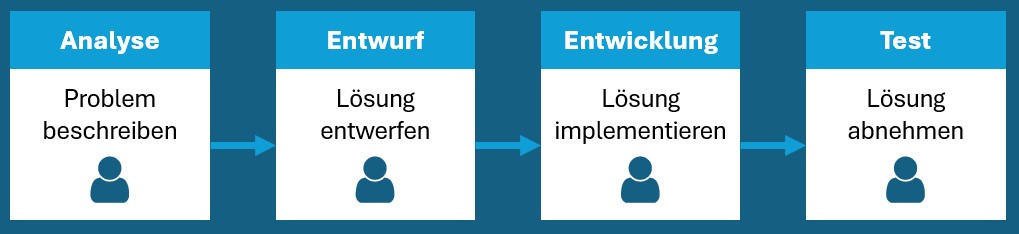

Bevor wir weiter untersuchen, ob menschliche Tester ersetzt werden können, sollten wir überlegen, ob wir das überhaupt wollen. Dazu ein kleines Gedankenexperiment: Der Prozess der Softwareentwicklung lässt sich typischerweise in verschiedene Phasen beziehungsweise Aufgaben zerlegen: Analyse, Entwurf, Entwicklung und Test. Stand heute erledigen wir alle diese Aufgaben durch Menschen (siehe Abb. 3).

Abb. 3: Typische Aktivitäten in der Softwareentwicklung

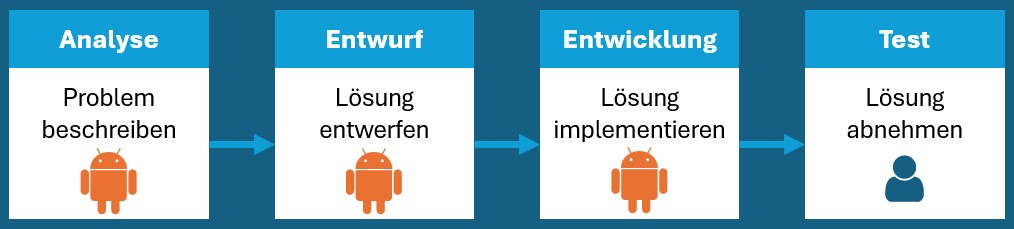

Angenommen wir sollten drei dieser Aufgaben in Zukunft von der KI übernehmen lassen – für welche würden wir uns entscheiden beziehungsweise für welche Aufgabe möchten wir gerne den Menschen behalten?

Rein intuitiv würden wir uns vermutlich dafür entscheiden, das Testen nicht oder zumindest als Letztes von der KI vollständig übernehmen zu lassen (siehe Abb. 4). Warum ist das so? Vermutlich, weil es sich schlicht falsch anfühlt, den Menschen bei Bewertung von Qualität und Entscheidung über den produktiven Einsatz von Software aus der Gleichung zu nehmen.

Abb. 4: Welche Aktivitäten in der Softwareentwicklung wollen wir durch KI ersetzen – und welche nicht?

Wir entwickeln Software für Menschen – nicht für Maschinen

Die meisten Systeme werden für die Nutzung durch Menschen entwickelt und nicht für die Nutzung durch Maschinen. Ein System, welches von Menschen genutzt werden soll, erfordert auch eine Prüfung durch Menschen, da nur sie beurteilen können, was sie möchten.

Als ein Beispiel zu prüfender Qualitätskriterien seien hier die Gebrauchstauglichkeit und Zugänglichkeit genannt. Diese sind inhärent auf den Menschen gerichtet und können entsprechend auch nur durch Menschen abschließend bewertet werden.

Testen ist mehr als Automatisierung

Viele Testaktivitäten lassen sich sinnvoll automatisieren – aber bei Weitem nicht alle. Analyse und Bewertung von textintensiven Inhalten, Generierung von Testfällen oder Testdaten oder Durchführung und Auswertung von Tests sind zwar relevante Aktivitäten, welche sich auch gut automatisieren lassen, beim Testen geht es aber um viel mehr. Der Mensch ist ein wesentlicher Faktor in Testprojekten, es geht um Kultur, Mindset, Kommunikation und Kollaboration. Der Mensch bringt seine Intuition, seinen Instinkt – eben seinen gesunden Menschenverstand mit. Er hat ein gutes Gespür für „just enough“ und ist in der Lage, Entscheidungen zu treffen. All diese Dinge lassen sich (zumindest noch nicht) automatisieren oder durch eine KI abbilden.

Der Mensch hat Stärken, wo die KI Schwächen hat

KI ist nicht für alles die Lösung. Beispielsweise zeigen Large Language Models (LLMs) zwar beeindruckende Fähigkeiten und Nutzen für eine Reihe von Anwendungsfällen, sie haben aber auch erhebliche Mängel, welche ihre Fähigkeit zum Verstehen und Begründen beeinträchtigen. Sie haben damit Einschränkungen hinsichtlich der Breite und Tiefe ihrer isolierten Anwendbarkeit ohne menschliche Aufsicht [1]:

- Sprachliches Verständnis: LLMs interpretieren menschliche Sprache oft falsch oder übersehen wichtige nuancierte Bedeutungen. Dies führt zu Ungenauigkeiten oder Fehleinschätzungen bei sprachlichen Aufgaben.

- Gesunder Menschenverstand: LLMs können die Welt nicht physisch wahrnehmen, ihnen fehlt es an visuellen, auditiven und taktilen Reizen und Erfahrungen. Dieser körperlose Zustand schränkt die Fähigkeit ein, die Feinheiten des gesunden Menschenverstands zu erlernen.

- Kontextuelles Verständnis: LLMs mangelt es an der Fähigkeit kontextsensitiven Denkens. Korrektes Denken ist jedoch eng mit der Fähigkeit verknüpft, den oft impliziten Kontext zu verstehen, in dem etwas steht.

- Visuell-räumliches Denken: LLMs fehlt ein grundlegendes räumliches Bewusstsein, es mangelt ihnen an Fähigkeit, Objekte mental zu visualisieren und ihre Beziehungen im Raum zu verstehen.

- Mathematisches Denken: LLMs haben Schwächen beim Durchführen einfacher mathematischer Denkprozesse. Zwar können sie oft richtige Antworten auf anspruchsvolle mathematische Fragen geben, sie müssen Berechnungen aber an andere Werkzeuge auslagern (z.B. Code oder Taschenrechner).

- Populärwissenschaftliches Wissen: LLMs sind anfällig für die Verbreitung und Verstärkung von Ungenauigkeiten, die in ihren Trainingsdaten enthalten sind, darunter wissenschaftliche Missverständnisse oder veraltete Informationen, die häufig online verbreitet werden.

- Relationales Verständnis: LLMs haben Schwierigkeiten im Verstehen und Interpretieren von zeitlichen, kausalen und konzeptionellen Beziehungen zwischen Entitäten. Das Lösen dieser Probleme erfordert häufig menschliches Verständnis und Intuition.

- Logisches Denken: LLMs werden mit Wissen trainiert, welches keine Kompetenz im logischen Denken zum Zeitpunkt der Schlussfolgerung garantiert. Menschliches Denken kann nur bis zu einem gewissen Grad nachgeahmt werden.

- Überanpassung: LLMs neigen dazu, sich an die Eigenheiten der Trainingsdaten anzupassen, auf Kosten einer breiteren Verallgemeinerung. Vorab trainierte Modelle können innerhalb der Grenzen ihrer Trainingsdaten hervorragend interpolieren, eine Extrapolation außerhalb dieser Grenzen kann jedoch schwieriger sein.

Diese Einschränkungen sollen die Möglichkeiten und das Potenzial von KI im Testen keineswegs in Abrede stellen, sie sollen aber verdeutlichen, dass es einen kritischen Umgang erfordert und dass es Herausforderungen im Testen mit sich bringt. Letztendlich brauchen wir den Menschen mit seinem kritischen Denkvermögen, seiner Intuition und seiner Fähigkeit des Um-die-Ecke-Denkens – was im Übrigen typische und wichtige Fähigkeiten von Testerinnen und Testern sind.

Die Einschränkungen von KI bedeuten Herausforderungen im Testen, bei denen der Mensch gefragt ist, zum Beispiel:

- Halluzination von Generative AI führen zu zweifelhaften Ergebnissen, welche erkannt und korrigiert werden müssen.

- Der starke Black-Box-Charakter von KI führt zu mangelnder Transparenz, Erklärbarkeit und Vertrauenswürdigkeit.

- Es gibt eine starke Abhängigkeit von der Qualität und Verfügbarkeit von Daten für Training, Validierung und Test von KI-Systemen.

- KI-Systeme sind nicht-deterministisch, wir haben es mit Wahrscheinlichkeiten zu tun und Testen ist kein rein binäres bestanden/nicht bestanden mehr.

- Der Nicht-Determinismus führt zu einer deutlichen Verschärfung des Testorakelproblems, welchem durch geeignete Testmethoden und -verfahren begegnet werden muss.

Testen von und mit KI erfordert den Menschen

Die Bestimmung der Qualität einer KI spielt sowohl beim Testen der KI eine Rolle, ist aber auch wichtig beim Einsatz von KI zum Testen. Bestimmte Qualitätsmerkmale, wie Vorurteilsfreiheit, Ethik, Fairness, Transparenz und Erklärbarkeit, können nur durch Menschen beurteilt werden.

Das Testen von KI kann zu Teilen maschinell und automatisiert erfolgen, in großen Teilen bedarf es aber auch hier des Menschen zur Qualitätsbewertung. Beispiele hierfür sind die Bewertung von Trainings-, Validierungs- und Testdaten und deren Qualität, die Auflösung des Testorakelproblems (z.B. durch geeignete Testverfahren wie metamorphes Testen, A/B Testen, Back-to-Back-Testen und exploratives Testen) sowie die Bewertung von Usability und Accessibility.

EU AI Act: Wir dürfen den Menschen gar nicht ersetzen

Die Europäische Union hat mit dem EU AI Act eine Richtlinie zum sicheren und ethischen Einsatz von KI vorgelegt. Ziel ist es, Innovation zu fördern, Vertrauen zu stärken und Risiken beim Einsatz von KI zu minimieren. In Bezug auf Menschen fordert der EU AI Act, dass „KI-Systeme von Menschen und nicht von der Automatisierung überwacht werden sollten, um schädliche Ergebnisse zu verhindern“ [2]. Der Mensch darf hier also gar nicht aus der Gleichung genommen werden, im Gegenteil, der Mensch muss eine zentrale Rolle bei der Entwicklung von KI-Systemen spielen.

Dies bedingt aber auch eine entsprechende Qualifikation der beteiligten Personen. Dies wird dann auch in Artikel 4 „KI-Kenntnisse“ des EU AI Act gefordert: „Die Anbieter und Betreiber von KI-Systemen ergreifen Maßnahmen, um nach bestem Wissen und Gewissen sicherzustellen, dass ihr Personal und andere Personen, die in ihrem Auftrag mit dem Betrieb und der Nutzung von KI-Systemen befasst sind, über ausreichende KI-Kenntnisse verfügen […]“ [3]. Hier können wir einen direkten Auftrag für uns als Tester ableiten, uns entsprechend mit KI zu befassen und weiterzubilden.

Wie wird sich das Berufsbild Testen verändern?

In Anbetracht der rasanten Entwicklungen von KI-Technologien und des enormen Potenzials für die Zukunft sollte offensichtlich sein, dass es keine Frage ist, ob sich das Berufsbild des Testens verändern wird, sondern wie – und wir sollten uns darauf einstellen.

Wie oben dargelegt, besteht aus meiner Sicht der primäre Nutzen von KI im Testen in der Effizienzsteigerung von Testaktivitäten und nicht darin, Menschen zu ersetzen. Für die Qualitätsbewertung von KI brauchen wird den Menschen zwingend, darüber hinaus dürfen wir den Menschen auch gar nicht ersetzen.

KI soll den Menschen unterstützen – nicht der Mensch die KI

KI ist eine Technologie, die durch den Menschen erschaffen wurde, weiterentwickelt wird und primär dem Menschen nutzen sollte. Die Vorstellung, dass die Entwicklung hin zu einer dem Menschen übermächtigen KI zwingend sei, ist nicht nur dystopisch, sondern lässt auch außer Acht, dass wir es selbst in der Hand haben, wie wir die Zukunft gestalten.

Natürlich können wir es nur bedingt beeinflussen, wie sich KI weltweit, getrieben durch die großen Tech-Konzerne, weiter etablieren wird. Aber wir sollten zumindest innerhalb unserer Disziplin beeinflussen können, ob der menschliche Tester zum Assistenten der KI wird oder umgekehrt. Wollen wir eine Zukunft, in der die KI uns die vielen coolen Tätigkeiten des Testens abnimmt und wir nur noch „Start“ und „Stopp“ klicken dürfen oder wäre es nicht wesentlich angenehmer, wenn die KI uns bei all den schnöden, langweiligen, lästigen, aufwendigen und wiederholten Tätigkeiten assistiert und wir damit das Testen für uns noch anspruchsvoller und attraktiver gestalten? Ich denke, dass wir es selbst in der Hand haben und die Zukunft des Testens so gestalten sollten.

Mehr Konzept- statt Produktwissen

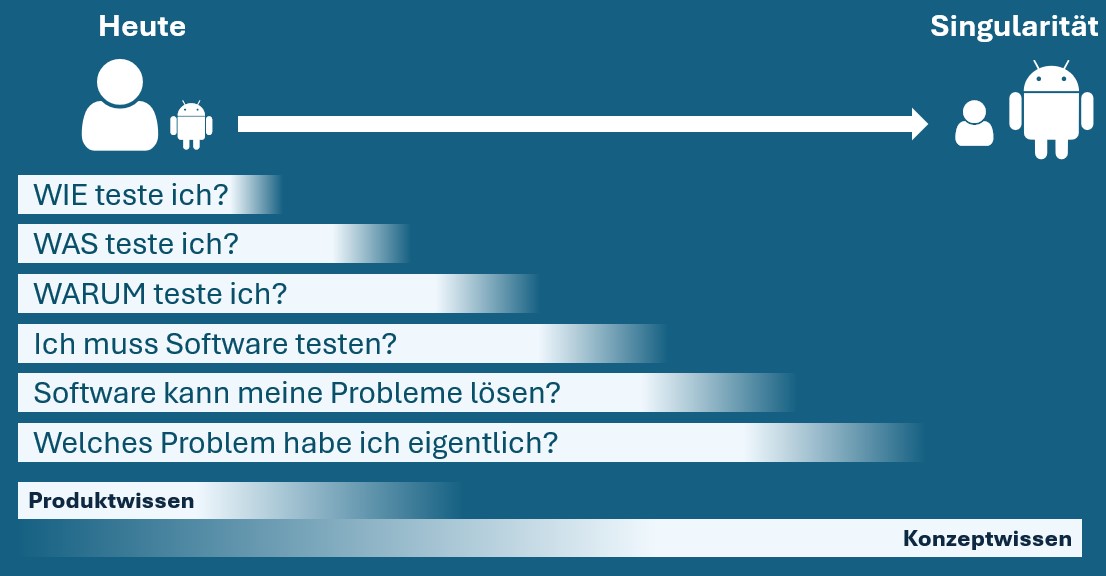

Unabhängig von dieser sehr großen (und zugegebenermaßen eher philosophischen) Frage, werden wir eine Verschiebung der Schwerpunkte unserer Arbeit vom Taktischen (Wie muss ich testen?) zum Strategischen (Warum muss ich testen?) erleben – zumindest, wenn wir nicht wollen, dass die KI unseren Job übernimmt. Wir sehen schon heute, wie LLMs sehr gut darin sind, sehr konkrete und technische Aufgaben zu lösen. Wenn ich nur gut darin bin, Testskripte in einem spezifischen Testautomatisierungsframework zu schreiben, ist die KI schon heute eine echte Konkurrenz für mich. Dieses taktische Wissen (auch Produktwissen genannt) wird als erstes durch KI ersetzt werden. Es ist daher ratsam, sich weg vom Produkt- und hin zum Konzeptwissen zu entwickeln und sich mehr auf das Was? und Warum? des Testens zu fokussieren.

Sollte irgendwann in ferner Zukunft tatsächlich doch die Singularität (siehe Abb. 5) kommen, dann wird auch das alles egal sein, die Tatsache, dass es Software gibt und diese getestet werden muss, wird dann keine Rolle mehr spielen. Dies sollte aber ein eher unwahrscheinlicher und – siehe oben – dystopischer Ausblick bleiben.

Abb. 5: Bei unseren Aufgaben als Tester müssen wir uns mit Fragestellungen und Aufgaben auf unterschiedlichen Abstraktionsgraden beschäftigen.

Konkrete, taktische Fähigkeiten (Produktwissen) werden früher durch KI ersetzt werden, als abstrakte, strategische Fähigkeiten (Konzeptwissen)

Die KI als Junior, der Mensch als Senior?

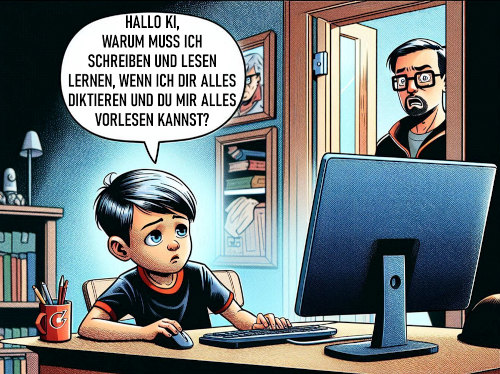

Bedeutet diese Verschiebung der Aufgaben vom Taktischen zum Strategischen dann auch, dass die KI künftig die Junior-Aufgaben übernimmt und der Mensch die Senior-Aufgaben? Was sich zunächst recht attraktiv anhört, kann aber nicht funktionieren, da ich kein Senior werden kann, ohne die Erfahrungen eines Juniors gemacht zu haben (siehe Abb. 6).

Abb. 6: Nimmt uns die KI das eigenständige Lernen und Denken ab? (Dall-E generiertes Bild, Cartoon basiert auf www.spiegel.de/fotostrecke/cartoon-destages-fotostrecke-142907.html)

Die KI wird uns nie die Aufgabe abnehmen zu bewerten, einzuordnen und kritisch zu analysieren. All das kann ich nicht leisten, wenn ich es nie selbst gemacht habe. Um konzeptionell arbeiten zu können, Arbeit delegieren und Ergebnisse bewerten zu können und um fundierte Entscheidungen treffen zu können, muss ich selbst die entsprechenden Erfahrungen gesammelt haben und eben als Junior tätig gewesen sein.

Wenn wir uns zu sehr oder sogar ausschließlich auf maschinelle Unterstützung verlassen, laufen wir Gefahr, wichtige Kompetenzen zu verlernen (wie ein Autofahrer, der durch die vielen Assistenz- und Navigationssysteme verlernt, selbstständig zu navigieren und Entscheidungen zu treffen) oder blind vertrauen zu müssen (vgl. den Automation Bias in der Testautomatisierung).

KI als Sparringspartner beim Testen

Eine treffendere Beschreibung der Zusammenarbeit von menschlichem Tester und KI ist die des Sparringspartners. Die KI ist der Sparringspartner des Testers, sie fordert ihn und hilft ihm dabei, sich weiterzuentwickeln, besser zu werden und sich auf seinen „Kampf“ vorzubereiten.

Eine andere Analogie ist die der Pilot-Co-Pilot-Beziehung in einem Cockpit: Sowohl Pilot als auch Co-Pilot sind prinzipiell in der Lage, ein Flugzeug alleine zu steuern, sie sind entsprechend qualifiziert und ausgebildet. Sie arbeiten jedoch zusammen, unterstützen und kontrollieren sich gegenseitig. Dieser Metapher folgend sollte der menschliche Tester der Pilot und die KI der Co-Pilot sein.

Skills für Tester

Ein guter Tester wird mithilfe von KI noch schneller bessere Ergebnisse erzielen – aber ein schlechter Tester wird ebenso noch schneller schlechtere Ergebnisse erzielen. Die KI wird uns unseren Tester-Job nicht wegnehmen, vielmehr wird uns der Job von jemand anderem weggenommen, der KI effektiv zu nutzen weiß. Oder um es positiv zu formulieren: Tester, die zum einen das Testhandwerk beherrschen und zum anderen KI sowohl zu testen als auch zu nutzen wissen, werden ihren Marktwert deutlich erhöhen.

Die wichtigste Grundlage ist und bleibt, den grundlegenden Prinzipien, Prozessen und Methoden des Testens zu folgen, wie wir sie seit vielen Jahren kennen und erfolgreich anwenden. Wir können nicht KI auf das Test-Problem werfen und damit ist alles erledigt. Tester-Kompetenz und -Erfahrung waren, sind und bleiben der Schlüssel für erfolgreiches Testen.

Ergänzen müssen wir diese Skills nun um grundlegende Fähigkeiten in Bezug auf KI-Systeme und -Technologien, zum Beispiel:

- Kenntnisse in Machine Learning, Data Quality Analytics usw.,

- Kenntnisse in der Nutzung von Generative AI und Interpretation deren Ergebnisse (z.B. Prompt Engineering/Crafting),

- Kenntnisse relevanter Teststrategien und -methoden für Testen von KI und Testen mit KI,

- Weiterentwicklung vom Produkt- zum Konzeptwissen.

Der Mensch wird nicht ersetzt

Durch die Effizienz- und Produktivitätssteigerung durch den Einsatz von KI werden wir in immer kürzeren Zyklen immer mehr Software produzieren und brauchen dabei den Menschen zwingend. Um dabei zu verhindern, dass die menschlichen Tester zum Bottleneck werden, kann ich mir gut vorstellen, dass wir im Bereich des Testens sogar auf mehr Menschen angewiesen sein werden als zuvor.

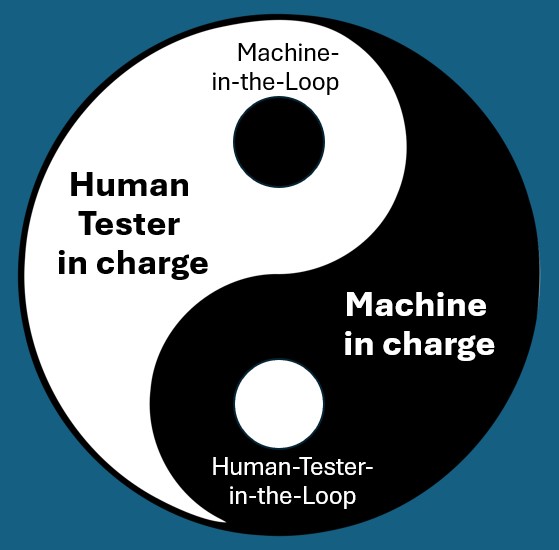

Human-in-the-Loop und Machine-in-the-Loop

Die Zukunft, auf die wir uns vorbereiten sollten, ist keine, in der wir entweder mit oder ohne KI arbeiten werden. Wir werden in verschiedenen Bereichen unterschiedliche Stufen der Autonomie erleben: Im Testprozess werden verschiedene Testaktivitäten unterschiedlich stark durch KI unterstützt werden. Die Aktivitäten, die schon heute einen hohen Automatisierungsgrad haben, werden als erstes und am stärksten durch KI-Werkzeuge und -Assistenten unterstützt (insbesondere Testdurchführung). Andere Testaktivitäten hingegen werden einen hohen manuellen Anteil behalten (insbesondere das Testmanagement).

Menschlicher Tester und Maschine werden komplementär zusammenarbeiten, in manchen Bereichen wird der Mensch in der Führung sein – unterstützt von der Maschine – und in anderen Bereichen wird die Maschine in der Führung sein – mit dem Human-in-the-Loop (siehe Abb. 7).

Abb. 7: Mensch und Maschine ergänzen sich gegenseitig im Testen. Manchmal ist der Mensch in der Führung, unterstützt durch die Maschine, manchmal ist die Maschine in der Führung, unterstützt und überwacht durch den Menschen

Online-Ressourcen

[1] S. Williams, J. Huckle, Easy Problems That LLMs Get Wrong, arXiv:2405.19616, 2024, siehe: arxiv.org/abs/2405.19616

[2] KI-Gesetz, EP, 19.6.2024, siehe: www.europarl.europa.eu/topics/de/article/20230601STO93804/kigesetz-erste-regulierung-der-kunstlichen-intelligenz

[3] Article 4: AI literacy, EU AI Act, Future of Life Institute, 2025, siehe: artificialintelligenceact.eu/de/article/4