BI-Spektrum: Wie hoch ist der Prozentsatz von Unternehmen, die heute Datenvirtualisierung nutzen?

Alberto Pan: Laut Gartner liegt der Anteil großer Unternehmen, die Datenvirtualisierung nutzen, zwischen 30 und 35 Prozent. Dieser Anteil ist in den letzten Jahren stark gewachsen. Heute ist es die am dritthäufigsten genutzte Methode für Datenintegration nach ETL und Datensynchronisierung, aber vor Datenstreaming.

BI-Spektrum: Denodo erklärt, dass Datenvirtualisierung, auch DV genannt, die überlegene Methode für Datenintegration ist. Wieso nutzen nicht mehr Unternehmen das Verfahren?

Alberto Pan: Wir sehen DV nicht unbedingt als Ersatz zum Beispiel für ETL, sondern auch als Ergänzung. Wenn es zum Beispiel um die Extraktion von Daten aus operativen Systemen in die analytischen Systeme geht, ergibt die Nutzung von ETL an vielen Stellen durchaus Sinn.

BI-Spektrum: Ich dachte, wenn DV genutzt wird, kann man direkt Daten aus den operativen Systemen nutzen, ohne sie erst in ein analytisches System zu übertragen. Stimmt das nicht?

"Je enger ein Endbenutzer mit den Daten umgeht, je näher man an den konkreten Use-Case herankommt, desto sinnvoller ist Datenvirtualisierung."

Alberto Pan: Doch. Das kann man so machen. Das ist aber nicht die häufigste Anwendung.

Normalerweise wird DV genutzt, wenn Unternehmen mehrere verschiedene Analysesysteme wie Data Warehouses oder Data Lakes einsetzen. In größeren, international agierenden Companies ist das in der Regel der Fall. Ohne DV mussten sie für ihre verschiedenen Use-Cases entsprechende Data Marts anlegen. Das brauchen sie jetzt nicht mehr zu tun. Sie können die Daten mit DV so zusammenziehen, wie sie sie benötigen. Das geht nicht nur einfacher als der Aufbau eines Data Mart, sondern ist auch viel flexibler und sehr viel schneller. Je enger ein Endbenutzer mit den Daten umgeht, je näher man an den konkreten Use-Case herankommt, desto sinnvoller ist DV. Es bringt einfach die Geschwindigkeit und Flexibilität, die der Endnutzer zum Beispiel im Bereich Analytics Self-Service benötigt.

BI-Spektrum: Stimmen Sie der Aussage zu, dass Datenvirtualisierung vor allem für Unternehmen interessant ist, die in Sachen Datenanalyse schon eine Weile unterwegs sind, also bereits mehrere Data Warehouses unterhalten und viele Data Marts?

"Datensilos sind gerade für große, verteilte Unternehmen nahezu unvermeidlich. Mit dem Cloud-Trend verstärkt sich die Silobildung weiter."

Alberto Pan: Ja. Etwa 90 Prozent unserer Kunden sind Großunternehmen mit mehr als einer Milliarde Umsatz. Wir zählen viele Unternehmen der Fortune-500- oder Global-200-Liste zu unseren Kunden. Größere Unternehmen haben in der Regel eine verteilte Organisation, mit mehreren Zentren, die eine gewisse Autonomie besitzen. Das bringt häufig auch verteilte Systeme mit sich, auch im Analytics-Bereich, und damit auch die Notwendigkeit, Daten zu integrieren. Mit Datenvirtualisierung schaffen die Unternehmen einen zusätzlichen Layer – man kann es auch Data Fabric oder virtuelles Data Warehouse nennen –, der es ihnen erlaubt, den verschiedensten Use-Cases die Daten in der gewünschten Form zur Verfügung zu stellen, ohne dass neue physische Strukturen aufgebaut werden müssten.

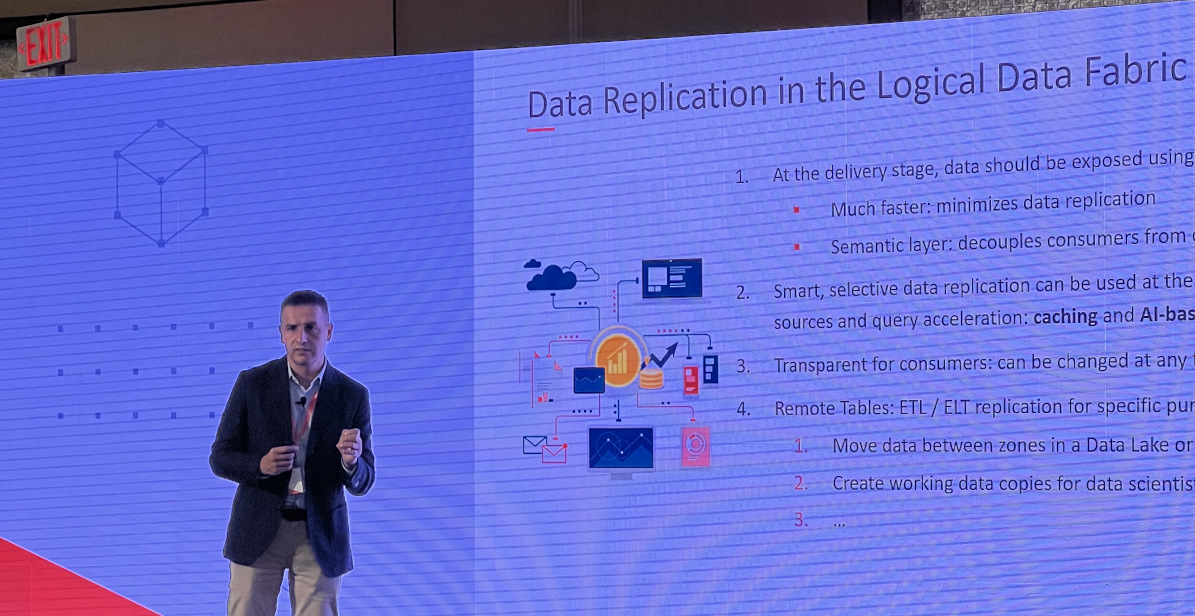

Alberto Pan auf einem Event

BI-Spektrum: Apropos Data Mesh und Data Fabric – wie passt DV in diese Architekturen?

Alberto Pan: Ein zentraler Gedanke des Data Fabric ist, verschiedene analytische Systeme für unterschiedliche Aufgaben zu betreiben und diese Struktur über eine Datenplattform zu versorgen, die Daten zur Verfügung stellt, eine einheitliche Semantik anbietet und durch einen zentralen Zugang Sicherheitsregeln und Governance durchzusetzen hilft. Deshalb ist Datenvirtualisierung die perfekte Technologie für Data Fabrics. Data Mesh geht darüber hinaus. Es ist mehr als ein technologisches Konzept. Es hat auch starke organisatorische und kulturelle Komponenten.

BI-Spektrum: Können Sie uns noch einige konkrete Beispiele geben, die mit Datenvirtualisierung adressiert werden?

"Wenn sich Self-Service im Analytics-Bereich nicht durchsetzt, bleibt der Anspruch an die Demokratisierung von Daten und ihrer Analyse bloßes Gerede."

Alberto Pan: Self-Service Analytics wäre eine typische Anwendungskategorie. Wenn man Business-Usern Daten so zur Verfügung stellt, dass sie einfach zu nutzen sind, dann funktioniert das mit Denodo wunderbar.

Viele unserer Kunden im Regierungsbereich oder im Gesundheitswesen haben Denodo genutzt, um die vielen verschiedenen Dashboards zu COVID-Themen zu betreiben, die sie ihren Institutionen oder den Endverbrauchern angeboten haben.

Ein anderes Beispiel sind hybride Datenarchitekturen, bei denen Unternehmen ihre Analytics-Initiativen in der Cloud ansiedeln, während sie andere Vorhaben On Premises realisieren. Das wirft auch wieder Datenintegrationsfragen auf, die wir beantworten können. Nehmen Sie zum Beispiel den australischen Bergbaukonzern BHP. Er unterhält große Rechenzentren in Australien, Nord- und Südamerika, Asien und Europa sowie in der AWS-Cloud. Sie nutzen Denodo, um einen Layer einzurichten, der als Data Fabric sämtliche ihrer Rechenzentren umspannt. Auf diese Weise können sie an jedem Standort mit den Daten aller Standorte arbeiten. Für Data Scientists eignet sich Denodo genauso wie für Business-User im Self-Service. Sie zielen zwar auf andere Zusammenhänge ab, aber die Bereitstellung der Daten funktioniert genauso wie bei den Business-Usern.

Ein weiterer wichtiger Anwendungsfall ist Data Sharing in großen Unternehmen. Bei einem großen, weltweit tätigen Halbleiterhersteller sind wir zentraler Bestandteil des Data Mesh. Die einzelnen Standorte definieren die von uns unterstützten Datenprodukte, die sie in Datenkatalogen und -märkten präsentieren und über REST-APIs bereitstellen.

BI-Spektrum: Das letzte Gespräch zwischen BI-Spektrum und Denodo hat vor fünf Jahren stattgefunden. Was waren die größten Veränderungen in dieser Zeit?

Alberto Pan: Denodo ist heute ein viel größeres Unternehmen. Wir zählen über 1000 Kunden, haben Niederlassungen in mehr als 20 Ländern, unsere Mitarbeiterschaft hat sich verdreifacht, die Umsätze verzehnfacht. Es war eine gute und herausfordernde Zeit für uns. Natürlich hat sich aber auch unser Produktportfolio entwickelt. Vor fünf Jahren konzentrierten wir uns fast ausschließlich auf Datenvirtualisierung und Datenintegration. Heute können wir praktisch sämtliche grundlegenden Komponenten anbieten, um Data Fabrics zu bauen. Zum Beispiel bieten wir einen eigenen Datenkatalog, integrieren eine MPP-Engine für die massiv parallele Verarbeitung von Daten und können einige Funktionen vorweisen, die AI nutzen. Damit verbessern wir die Performance oder produzieren automatisierte Empfehlungen.

BI-Spektrum: Was verstehen Sie unter einem Datenkatalog und was hat er für eine Funktion?

Alberto Pan: Marktteilnehmer bezeichnen damit unterschiedliche Produkte. Unser Datenkatalog ist ein Self-Service-Katalog, der sich nicht wie ein Inventory-Katalog an Data Stewards wendet, sondern vielmehr an Datennutzer im Business. Er hat die Funktion eines Marktplatzes, auf dem sich die Kunden aussuchen können, welche Daten sie in welcher Form sehen wollen. Sie können sich das vorstellen wie eine E-Commerce-Seite, auf der Sie Produkte bestellen.

BI-Spektrum: Was tut Denodo mit AI genau?

Alberto Pan: Denodo genießt bei seinen Kunden ein großes Privileg: Meistens laufen sämtliche Daten, die ein Unternehmen analysiert, über unsere Plattform. Damit haben wir einen sehr genauen Blick auf das, was in der Architektur geschieht. Wir wissen, welche Daten wie analysiert werden, welche Daten zusammen angesehen werden, welche Tools dafür genutzt werden. Denodo hat auf einen Blick alle aktiven Metadaten für sämtliche Analysen, die im Unternehmen laufen. Und diese Metadaten wiederum können gut genutzt werden, um AI-Prozesse wie automatische Empfehlungen oder regelrechte Automatisierungen von Auswertungen zu realisieren. Außerdem hilft AI den Nutzern, neue Queries zu beschleunigen und zu präzisieren, sodass das System insgesamt schneller Ergebnisse liefern kann.

BI-Spektrum: Welche großen Herausforderungen haben Nutzer in den kommenden Monaten zu bewältigen?

Alberto Pan: Die Überbrückung von Datensilos. Datensilos sind gerade für große, verteilte Unternehmen nahezu unvermeidlich. In solchen Unternehmen treffen die Verantwortlichen an den unterschiedlichen Standorten verschiedene Entscheidungen. Sie wählen die Tools, die für ihre spezielle Aufgabe die besten sind. Mit dem Cloud-Trend verstärkt sich die Silobildung weiter. Wir brauchen ein effektives Werkzeug, um Silos agil aufzubrechen. Ohne ein solches Werkzeug sind die viel zitierten Data-based Companies schlechterdings unmöglich, weil sie sonst niemals den Überblick bekommen, sondern nur immer in ein bestimmtes Silo hineinschauen bekommen. Es kann kein Gesamtbild erzeugt werden. Ohne solche agilen Werkzeuge muss das Business Wochen warten, damit neue Datenbedarfe befriedigt werden können. Dann kann sich keine datenbasierende Kultur entwickeln.

BI-Spektrum: Wie sehen Sie die weitere Entwicklung von Self-Service in Analytics?

Alberto Pan: Das ist nach wie vor ein starker Trend, und hier gilt das Gleiche wie für das Aufbrechen von Silos. Wenn sich Self-Service im Analytics-Bereich nicht durchsetzt, bleibt der Anspruch an die Demokratisierung von Daten und ihrer Analyse bloßes Gerede und die Vision eines datengetriebenen Unternehmens gerät zur Makulatur. Und heute haben wir die technischen Möglichkeiten dazu, das Wirklichkeit werden zu lassen.

- title

- Der Autor

- subtitle

- ALBERTO PAN

- introduction

- Aleberto Pan arbeitet seit 2005 bei Denodo. Heute ist er als Chief Technology Officer für das Unternehmen tätig. Er studierte Computer Science an der Universität Coruna und promovierte dort im gleichen Fach. Er ist seiner Alma Mata verbunden geblieben und lehrt dort heute Computer Science als Associate Professor.

- image

- Pan_Alberto_2

Das Interview führte Christoph Witte, Chefredakteur BI-Spektrum.